Para hacer nuestro contenido accesible a más usuarios, hemos traducido este artículo del inglés al español mediante traducción automática. Haz clic aquí para leer el artículo original. Si detectas algún problema en el contenido, no dudes en escribirnos a report-osteam@semrush.com.

¿Qué es el Crawl Budget?

El presupuesto de rastreo es la cantidad de tiempo y recursos que los robots de los motores de búsqueda dedican a rastrear tu sitio web e indexar sus páginas.

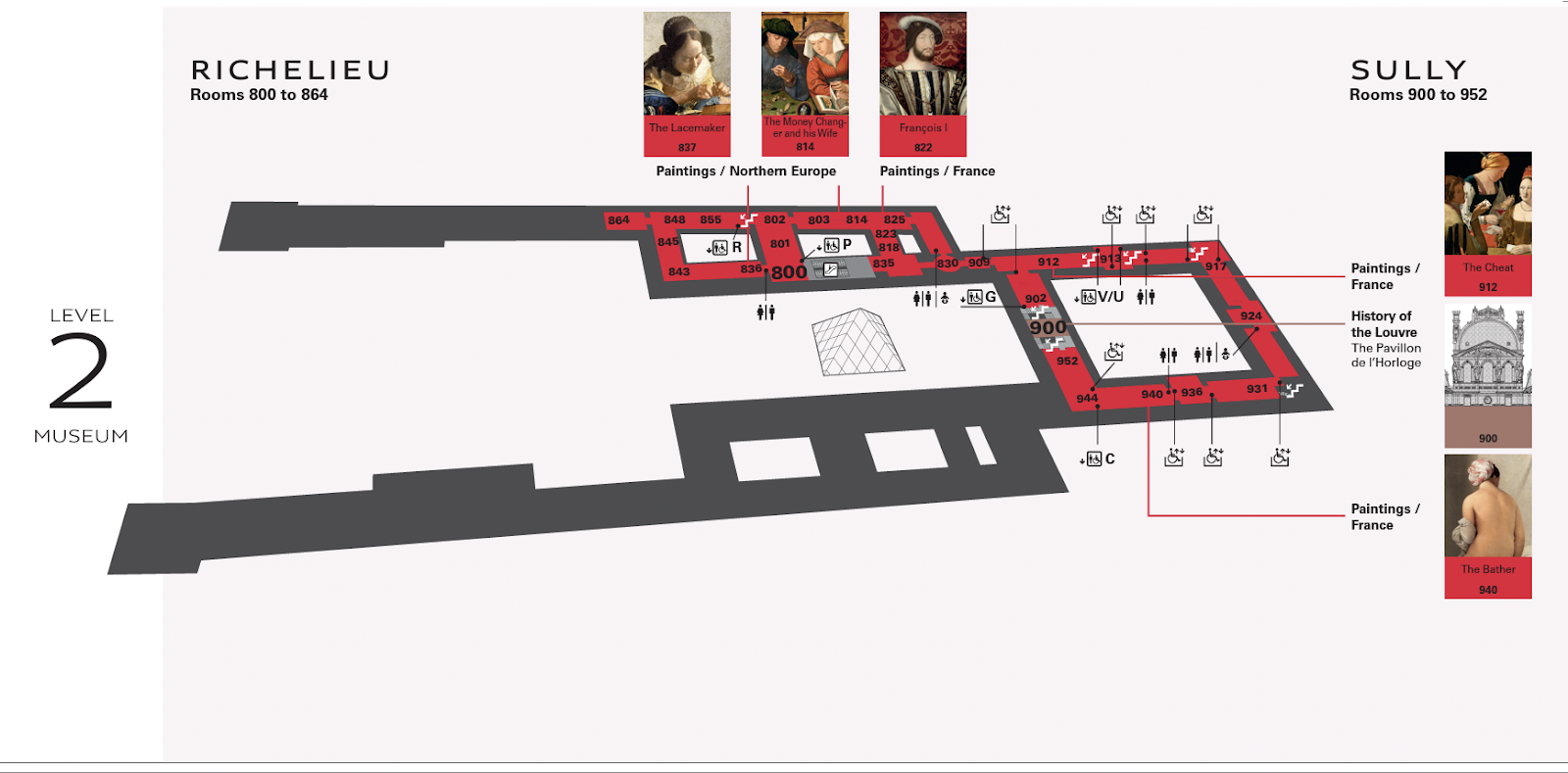

Piénsalo así: visitas el Louvre, que tiene cientos de exposiciones repartidas por varias plantas.

Sin un mapa, podrías perderte el arte que realmente querías ver.

Para hacer el mapa que tienes en tus manos, alguien tendría que recorrer cada sala, marcando qué cuadros figuraban allí.

En esta metáfora, el cartógrafo del Louvre es como un Googlebot rastreando un sitio web.

Un equipo de cartógrafos corriendo constantemente por el Louvre ralentizaría la experiencia de los espectadores.

De forma similar a como los robots que rastrean constantemente tu sitio web lo ralentizarían.

Así que los cartógrafos necesitan un tiempo determinado para actualizar el mapa, igual que Googlebot necesita saber con qué frecuencia debe rastrear tu sitio web.

¿Afectan los presupuestos de rastreo al SEO?

El presupuesto de rastreo no es un factor de clasificación para el SEO técnico.

Pero si Googlebot experimenta errores de rastreo que le impiden leer e indexar tu contenido, las posibilidades de que tus páginas aparezcan en las páginas de resultados de los motores de búsqueda(SERP) son escasas.

Tampoco quieres que los robots de Google rastreen tu sitio todo el tiempo.

Superar el presupuesto asignado para rastrear un sitio web puede provocar ralentizaciones o errores en el sistema.

Eso puede hacer que las páginas se indexen tarde o no se indexen en absoluto, lo que da lugar a una peor clasificación en las búsquedas.

Google utiliza cientos de señales para decidir dónde debe colocar tu página. El rastreo determina si tu página aparece -no dónde- y no tiene nada que ver con la calidad del contenido.

¿Cómo determina Google el presupuesto de rastreo?

Cada sitio web tiene un presupuesto de rastreo único, controlado por dos elementos principales: la demanda de rastreo y el límite de rastreo.

Es importante comprender cómo funcionan y qué ocurre entre bastidores.

Demanda de arrastre

La demanda de rastreo se refiere a las ganas que tiene Google de rastrear tu sitio web.

Hay dos factores que afectan a esta demanda: la popularidad y la caducidad.

Popularidad

Google da prioridad a las páginas con más backlinks o a las que atraen más tráfico. Por tanto, si la gente visita tu sitio web o enlaza con él, el algoritmo de Google recibe señales de que tu sitio web merece rastreos más frecuentes.

Los backlinks ayudan especialmente a Google a averiguar qué páginas merece la pena rastrear. Si Google se da cuenta de que la gente habla de tu sitio web, querrá rastrearlo más para ver de qué se trata.

Ten en cuenta que el número de backlinks por sí solo no importa: los backlinks deben ser relevantes y proceder de fuentes autorizadas.

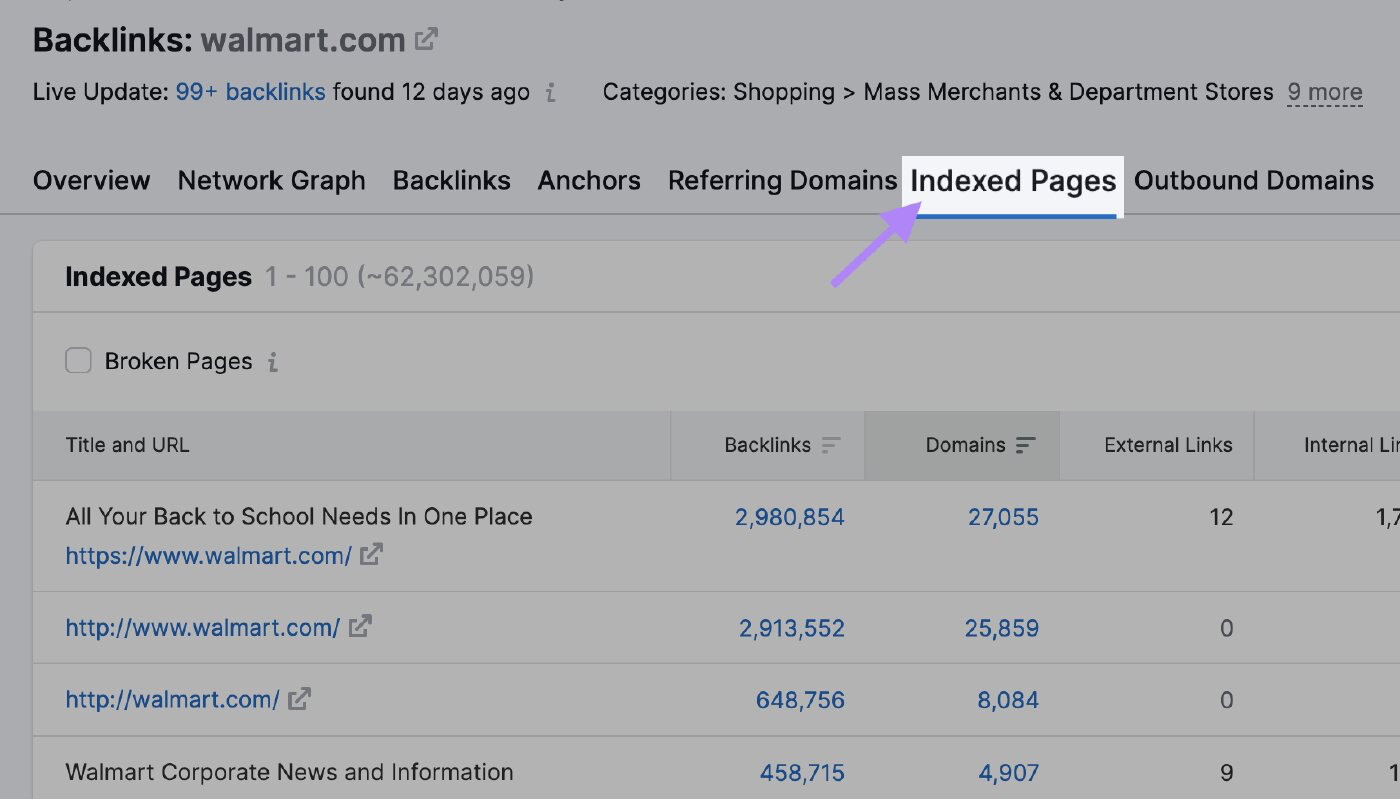

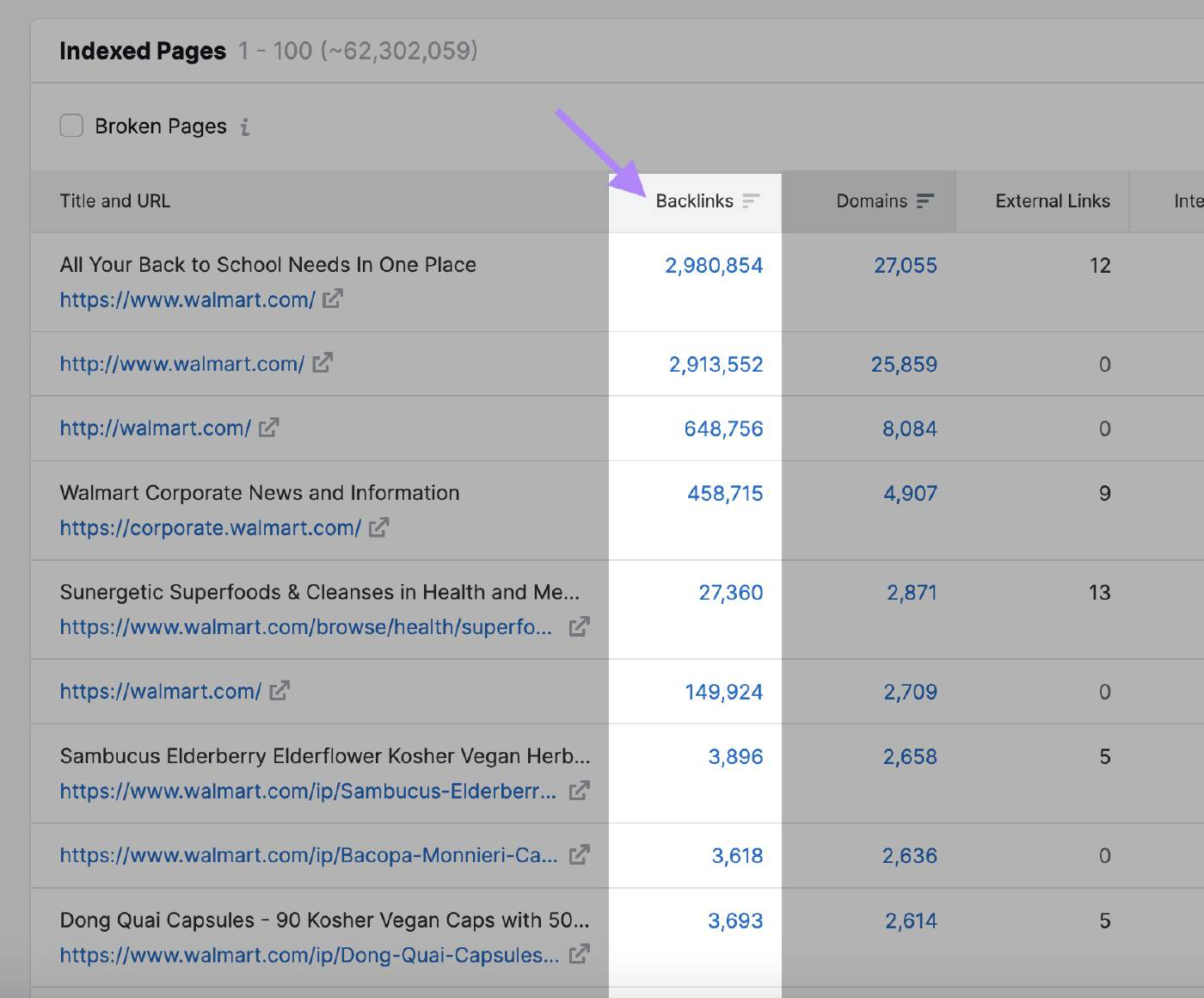

Puedes utilizar la herramienta Backlink Analytics de Semrush para ver qué páginas atraen más backlinks y pueden llamar la atención de Google. Introduce el dominio y haz clic en la pestaña "Páginas indexadas".

Aquí puedes ver las páginas con más backlinks:

Anquilosamiento

Googlebot no rastreará una página que no se haya actualizado en un tiempo.

Google no ha revelado la frecuencia con la que el buscador volverá a rastrear el sitio web. Sin embargo, si el algoritmo advierte una actualización general del sitio, los robots aumentan temporalmente el presupuesto de rastreo.

Por ejemplo, Googlebot rastrea con frecuencia los sitios web de noticias porque publican contenido nuevo varias veces al día.

En este caso, el sitio web tiene una gran demanda de rastreo.

Compáralo con un sitio web sobre la historia de obras de arte famosas que no se actualiza con tanta frecuencia.

Otras acciones que pueden indicar a Google que hay cambios que rastrear son:

- Cambio de nombre de dominio: Cuando cambias el nombre de dominio de tu sitio web, el algoritmo de Google necesita actualizar su índice para reflejar la nueva URL. Rastreará el sitio web para comprender el cambio y pasará las señales de clasificación al nuevo dominio.

- Cambio de estructura de URL: Si modificas la estructura de URL de tu sitio web cambiando la jerarquía de directorios o eliminando o añadiendo subdominios, los robots de Google tienen que volver a rastrear las páginas para indexar correctamente las nuevas URL.

- Actualizaciones de contenido: Las actualizaciones significativas del contenido de tu sitio web, como reescribir una gran parte de tus páginas, añadir páginas nuevas o eliminar contenido obsoleto, pueden atraer la atención del algoritmo y hacer que vuelva a rastrear tu sitio web.

- Envío del mapa del sitio XML: Actualizar tu mapa del sitio XML y volver a enviarlo a Google Search Console puede informar a Google de que hay cambios que rastrear. Esto es especialmente útil cuando quieres asegurarte de que Google indexa rápidamente las páginas nuevas o actualizadas.

Límite de velocidad de rastreo

El límite de velocidad de rastreo determina la rapidez con la que el bot puede acceder a las páginas web de tu sitio y descargarlas para preparar el contenido que se mostrará en los resultados de búsqueda.

Es la forma que tiene Google de asegurarse de que su rastreo no sobrecarga tus servidores.

El límite de rastreo evita que el bot atasque tu sitio web con demasiadas peticiones, lo que puede causar problemas de rendimiento.

Si tu sitio responde con rapidez, Google obtiene luz verde para aumentar el límite y entonces puede utilizar más recursos para rastrearlo.

Del mismo modo, si Google encuentra errores en el servidor o tu sitio se ralentiza, el límite disminuirá y Googlebot rastreará menos el sitio web.

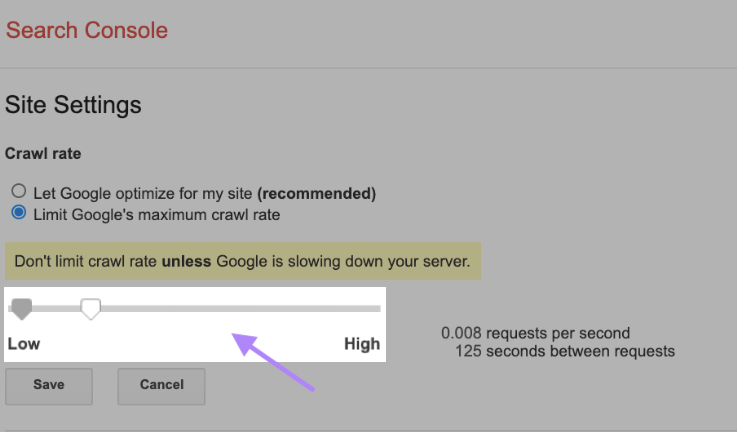

También puedes cambiar el límite de rastreo manualmente, aunque es importante hacerlo con precaución. Google sugiere no limitar la velocidad de rastreo a menos que tu servidor se esté ralentizando.

Para cambiar tu tasa de rastreo, ve a Configuración del sitio en Search Console y ajusta la barra. El ajuste suele tardar hasta dos días en aplicarse.

¿Cómo funciona el proceso de rastreo?

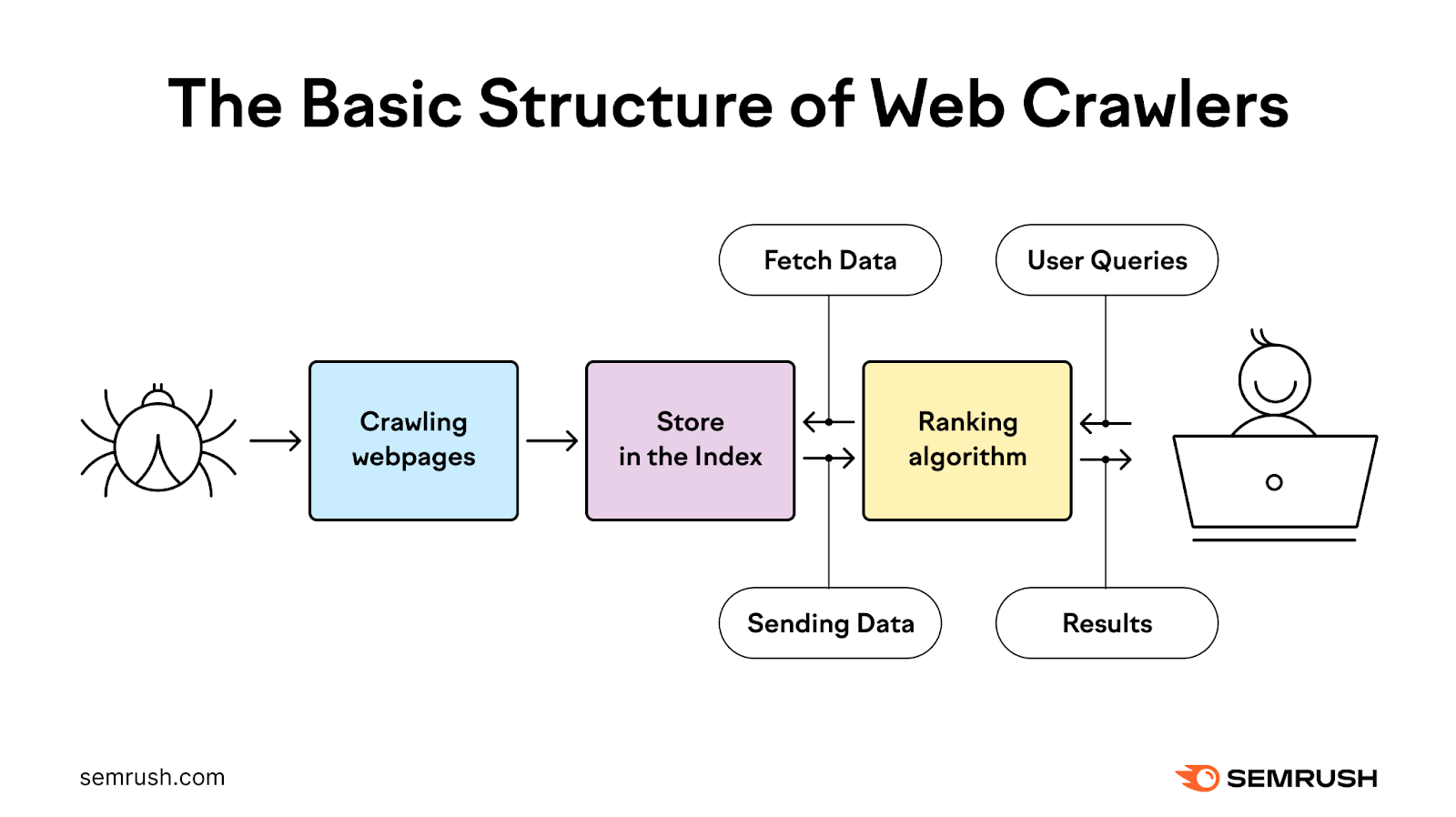

El proceso de rastreo utiliza robots para descubrir, rastrear, analizar e indexar páginas web con el fin de proporcionar a los usuarios los resultados de búsqueda más relevantes y de mayor calidad.

Comienza con una lista de direcciones web de rastreos anteriores y mapas del sitio XML que proporcionan los propietarios del sitio. Después, Google utiliza rastreadores web para visitar estas direcciones, leer la información y seguir los enlaces de esas páginas.

Los rastreadores vuelven a visitar las páginas que Google ya tiene en la lista para comprobar si han cambiado y también rastrean páginas nuevas.

Durante este proceso, el bot prioriza cuándo y qué rastrear en función de la demanda de rastreo, al tiempo que se asegura de que el sitio web puede gestionar las peticiones al servidor que realiza.

A continuación, procesa y pasa las páginas que rastrea correctamente a Google para que las indexe en los resultados de búsqueda.

La mayoría de las veces, Google rastrea eficazmente los sitios web más pequeños.

Cuando se trata de grandes sitios web con millones de URL, Google tiene que priorizar cuándo y qué rastrear y cuántos recursos debe dedicar.

Cómo comprobar tu actividad de rastreo

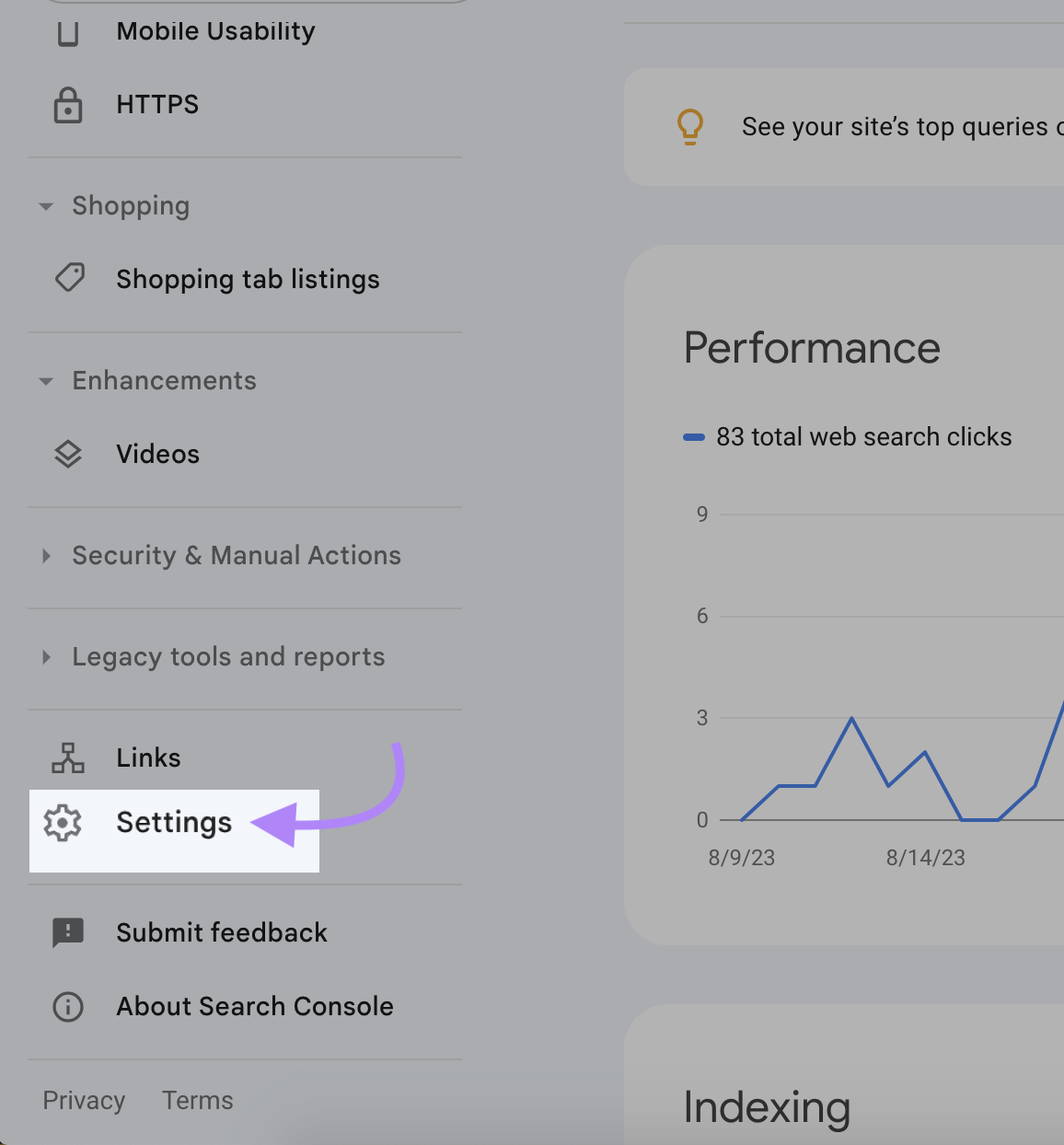

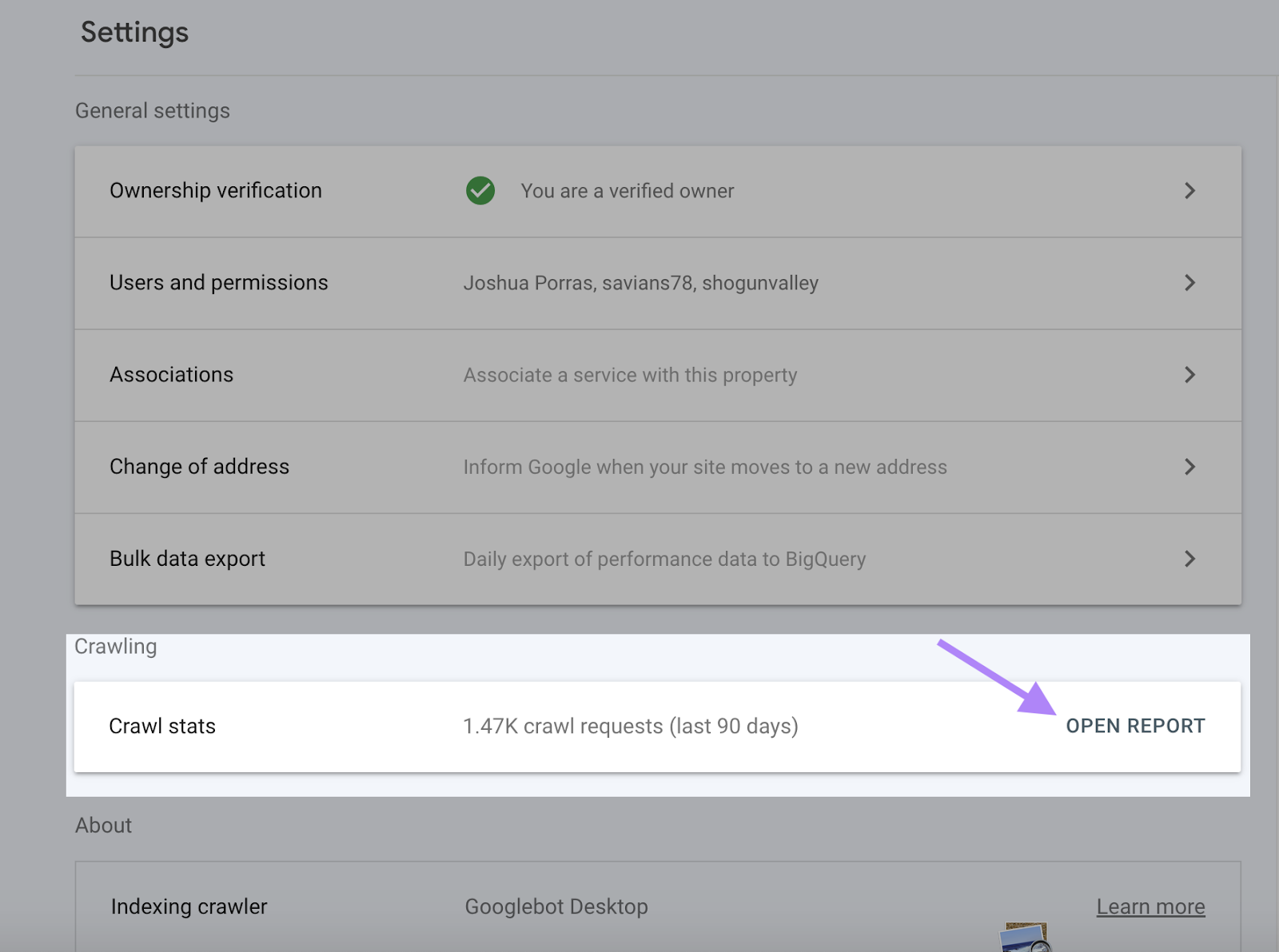

Google Search Console proporciona información completa sobre tu actividad de rastreo, incluidos los errores de rastreo y la tasa de rastreo, en el Informe de estadísticas de rastreo.

Tu Informe de estadísticas de rastreo te ayuda a comprobar si Google puede acceder a tu contenido e indexarlo. También puede identificar y solucionar cualquier problema antes de que caiga la visibilidad de tu sitio web.

Para acceder a tu Informe de estadísticas de rastreo, inicia sesión en Search Console y haz clic en "Configuración".

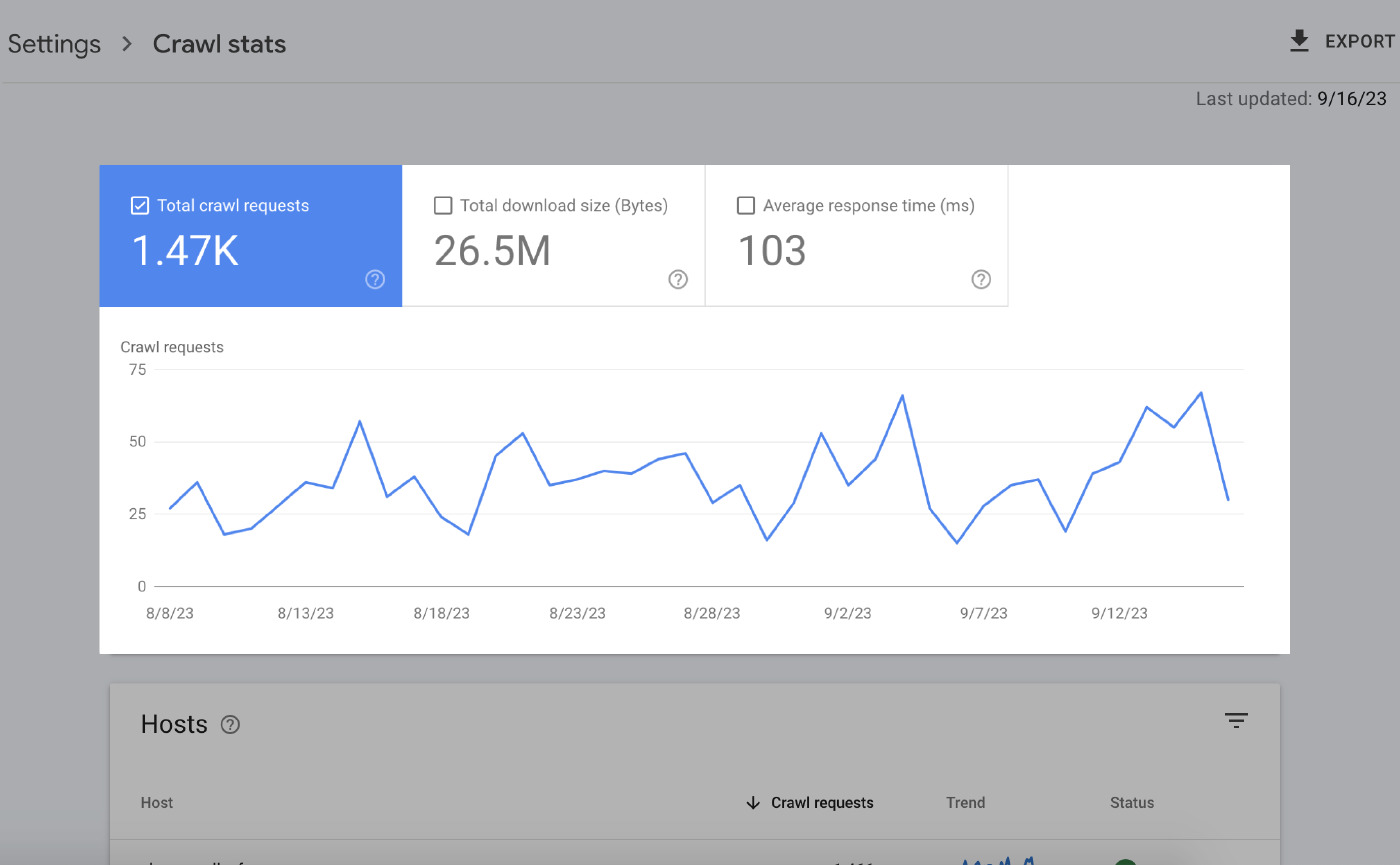

La página Resumen te da mucha información. Los elementos principales son:

Gráficos de tiempo extra

Los gráficos en tiempo real destacan tus datos de rastreo en los últimos 90 días.

Esto es lo que significa todo esto:

- Peticiones de rastreo totales: El número de peticiones de rastreo realizadas por Google en los últimos 90 días.

- Tamaño total de descarga: La cantidad total de datos descargados por los rastreadores de Google al acceder a tu sitio web durante un periodo determinado.

- Tiempo medio de respuesta: El tiempo que tarda el servidor de tu sitio web en responder a una petición del navegador de un usuario.

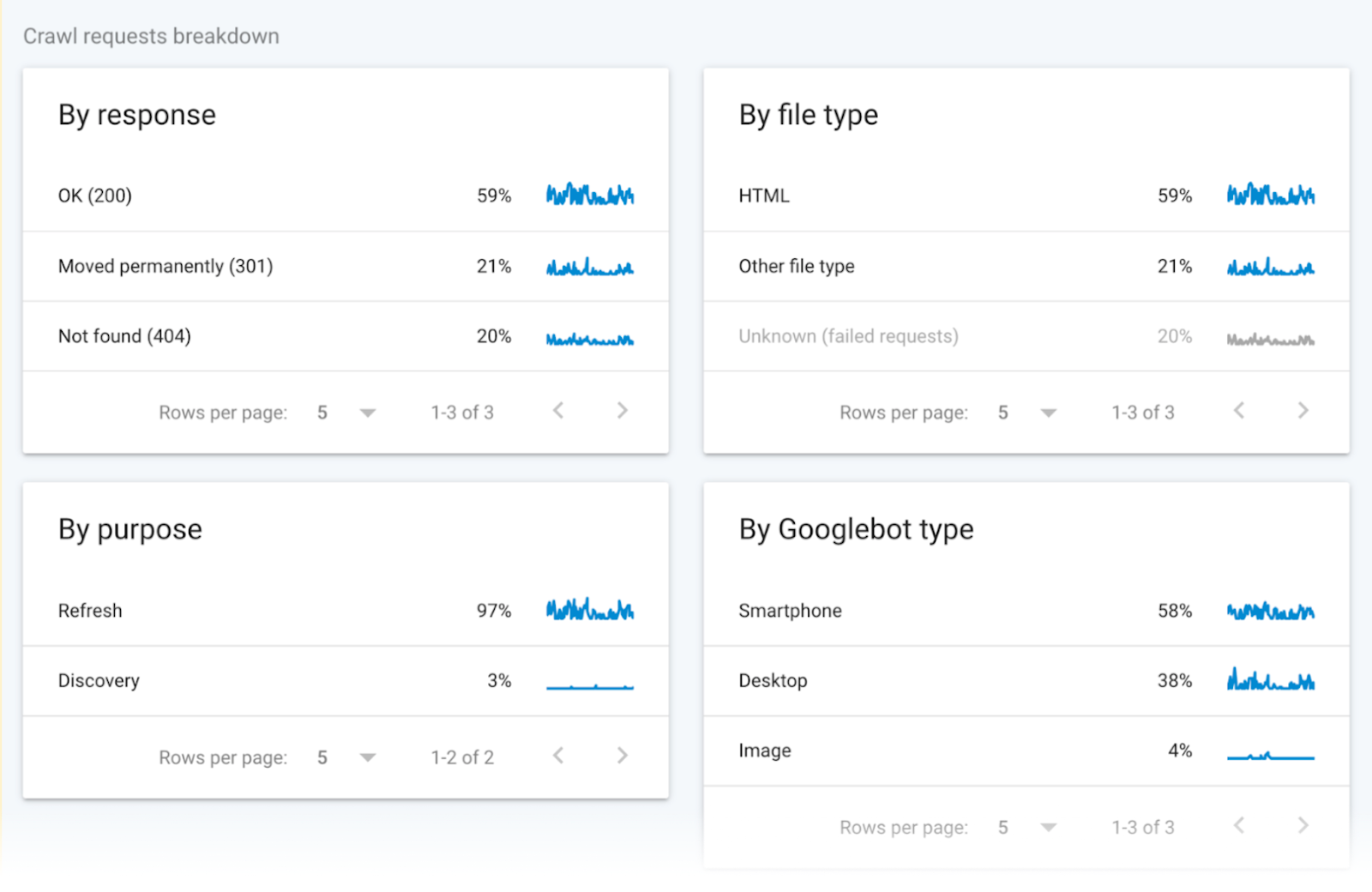

Datos de rastreo agrupados

Los datos de rastreo agrupados proporcionan información sobre las solicitudes de rastreo.

Los datos dividen estas solicitudes según el tipo de archivo URL, la respuesta, el tipo de Googlebot y el propósito de la solicitud (descubrimiento de una nueva página o actualización de una página existente).

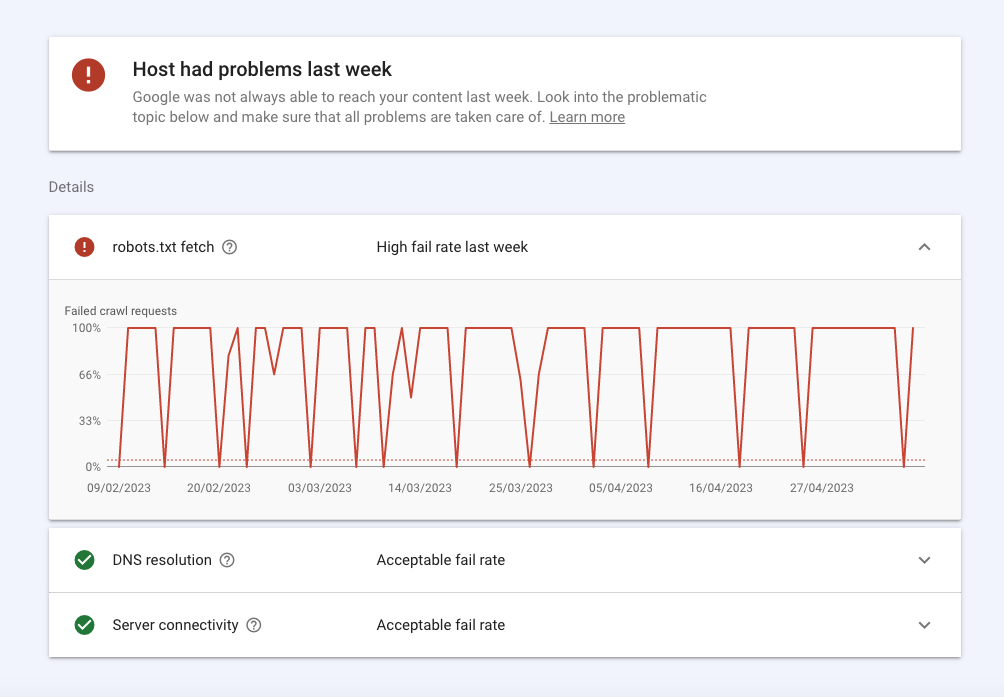

Estado del anfitrión

El estado del alojamiento muestra la disponibilidad general de tu sitio y si Google puede acceder a él sin problemas.

Aquí tienes un resumen:

- Los errores en la sección robots.txt significan que Google no ha podido rastrear tu sitio por alguna razón técnica. Robots.txt fetch te indica la tasa de fallos que experimentaron los robots cuando rastrearon tu archivo robots.txt. Aunque tu sitio no necesita un archivo robots.txt, debe devolver la respuesta satisfactoria 200 o 404 cuando se le solicite. Si Googlebot tiene un problema de conexión, como un estado HTTP 503, dejará de rastrear tu sitio.

- La resolución DNS te indica cuándo tu servidor DNS no reconoció tu nombre de host o no respondió durante el rastreo. Si encuentras un problema aquí, ponte en contacto con tu registrador para verificar que tu sitio está configurado correctamente y que tu servidor tiene una conexión a Internet activa.

- La conectividad del servidor te indica cuándo tu servidor no respondió o no proporcionó la respuesta completa. Si aquí observas picos o problemas de conectividad constantes, puede que tengas que hablar con tu proveedor para que aumente la capacidad o solucione los problemas de disponibilidad.

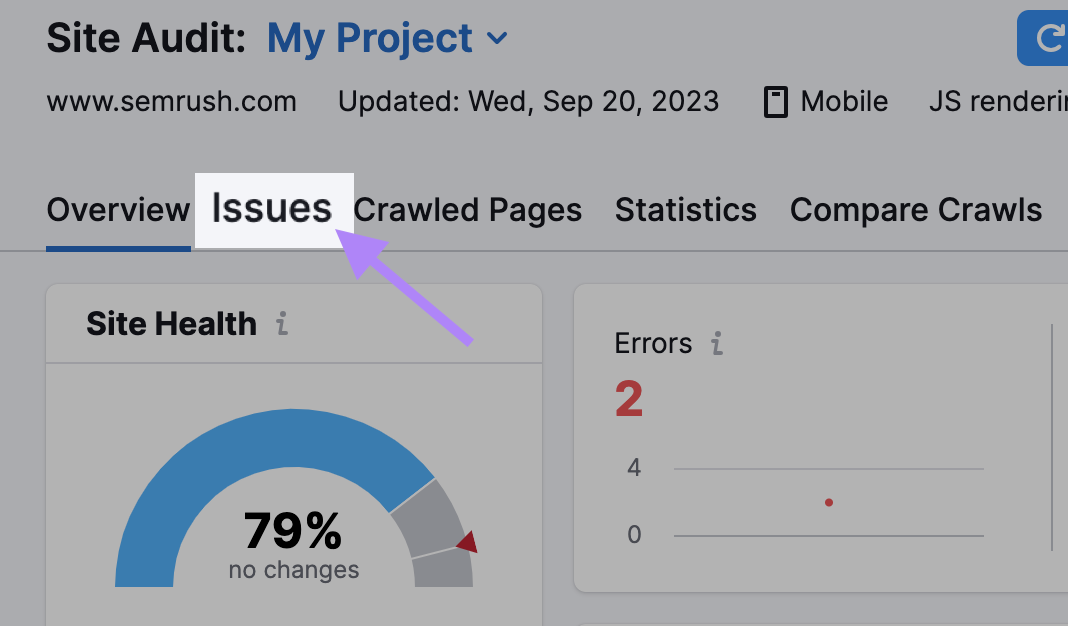

Cómo comprobar la rastreabilidad de tu sitio web con Site Audit

Utiliza la herramienta Auditoría del Sitio para que los SemrushBots rastreen tu sitio web y comprueben su estado.

La herramienta señala más de 140 problemas -incluidoel contenido duplicado y los enlaces rotos- que puedes identificar y solucionar.

Esto es lo que tienes que hacer

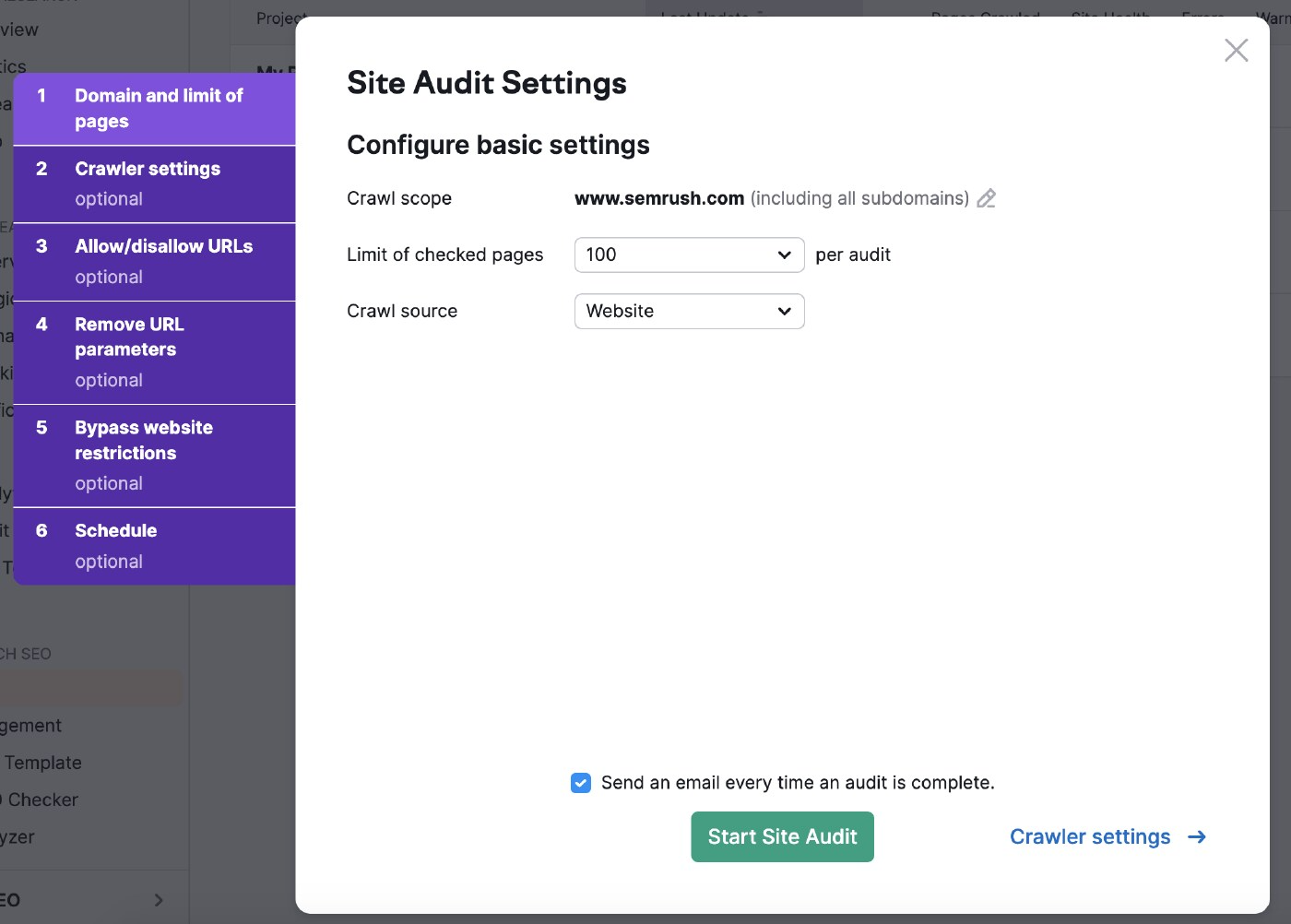

Finalizar los ajustes básicos

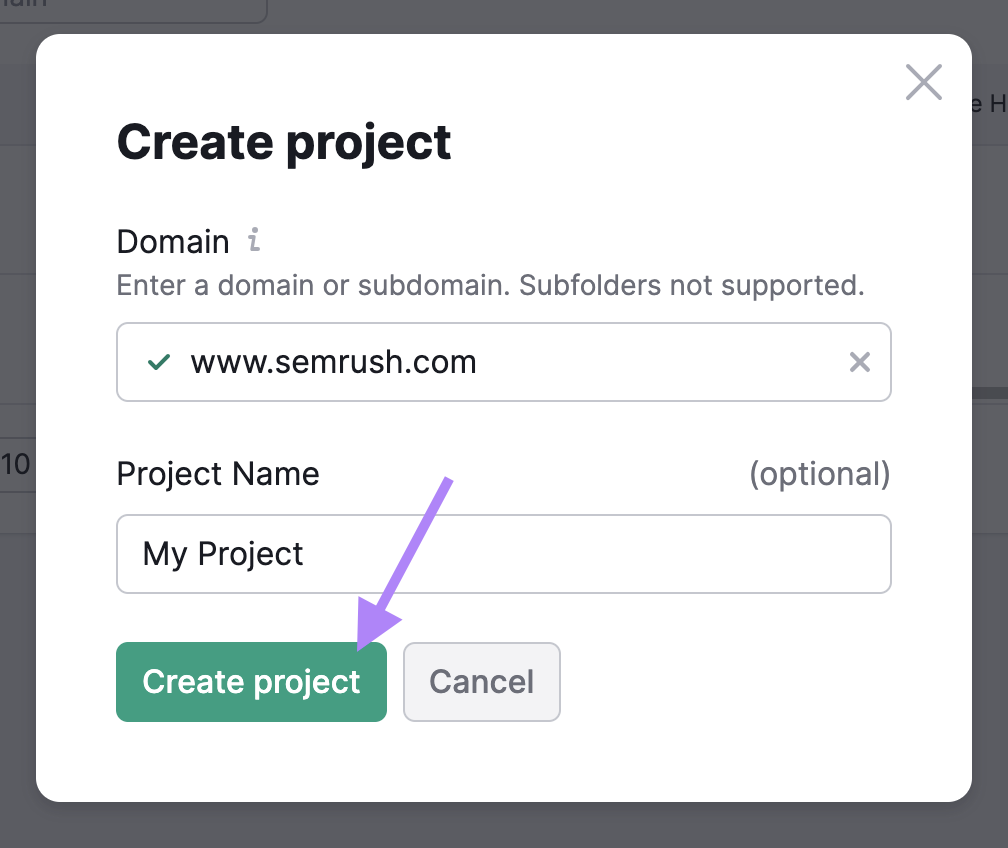

Ve a la herramienta Auditoría del Sitio y crea un nuevo proyecto si es tu primera auditoría.

A continuación, selecciona la configuración de la auditoría de tu sitio.

El ámbito de rastreo te permite acotar la búsqueda.

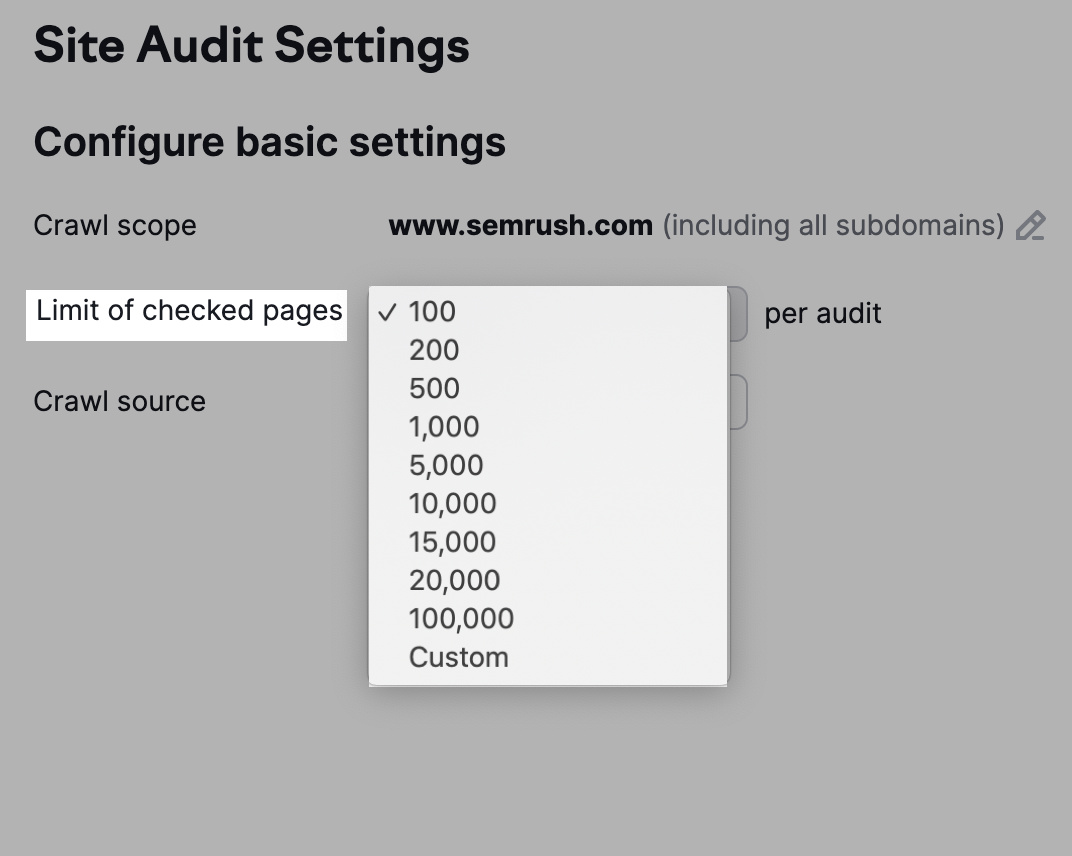

También puedes ajustar el número de URL a comprobar por auditoría en función de tu nivel de suscripción y de la frecuencia con que vayas a inspeccionar el sitio web.

Cuantas más páginas rastrees, mejor visibilidad obtendrás.

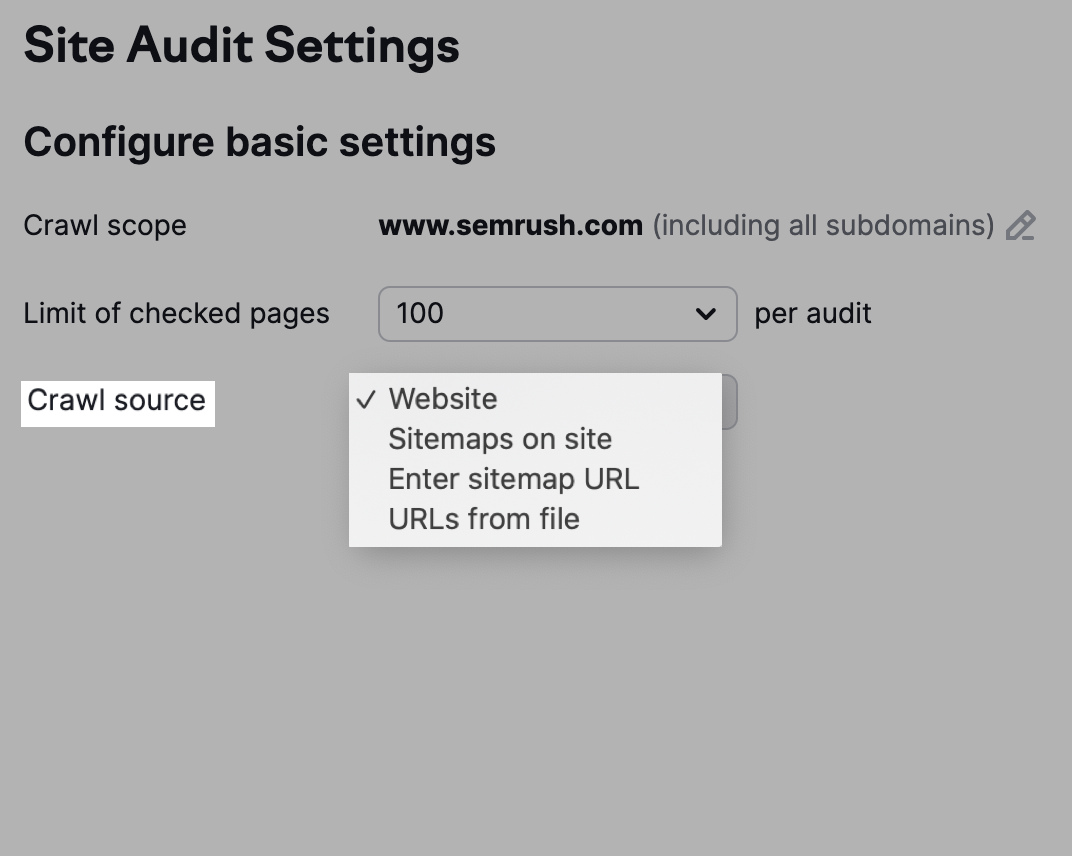

También tienes la opción de elegir tu fuente de rastreo.

Ten en cuenta que la opción " Sitioweb" hará que los robots rastreen tu sitio tal y como lo hace Google, mientras que un rastreo utilizando "Mapas del sitio en el sitio" utiliza las URL del mapa del sitio del archivo robots.txt.

Alternativamente, haz clic en "URLs desde archivo" para seleccionar las páginas que quieres que rastreen los robots.

Ajustar la configuración del rastreador

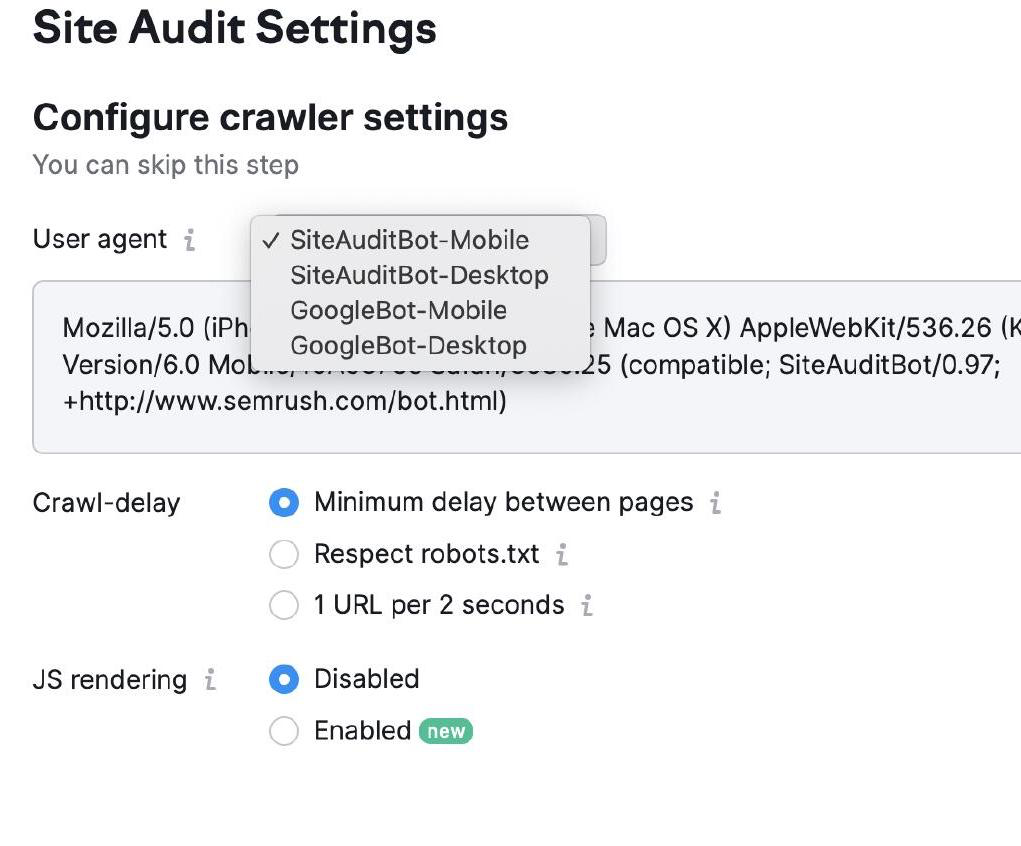

La Configuración del rastreador te permite elegir el tipo de bot que rastreará tu sitio web.

Puedes elegir entre Googlebot y SemrushBot y versiones para móvil y escritorio.

A continuación, selecciona tus ajustes de Retraso de arrastre. Los robots rastrean a velocidad normal con "retardo mínimo" y priorizan la experiencia del usuario en la configuración "1 URL cada 2 segundos".

Por último, selecciona "Respetar robots.txt" si tienes el archivo correspondiente y necesitas un retardo de rastreo específico.

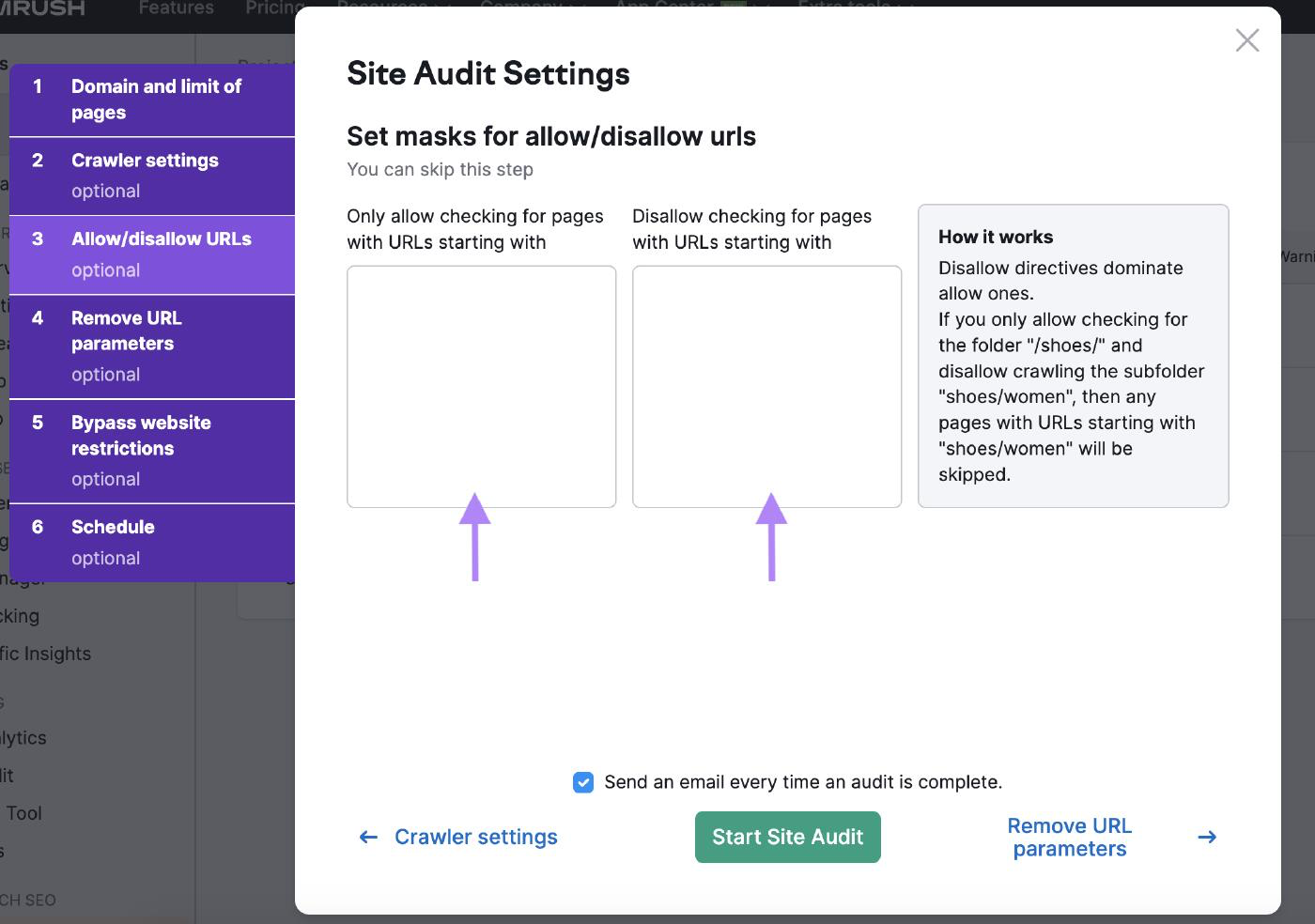

Permitir/No permitir URLs

Personaliza la auditoría de tu sitio con los ajustes de permitir/no permitir URL introduciendo las URL en sus casillas correspondientes.

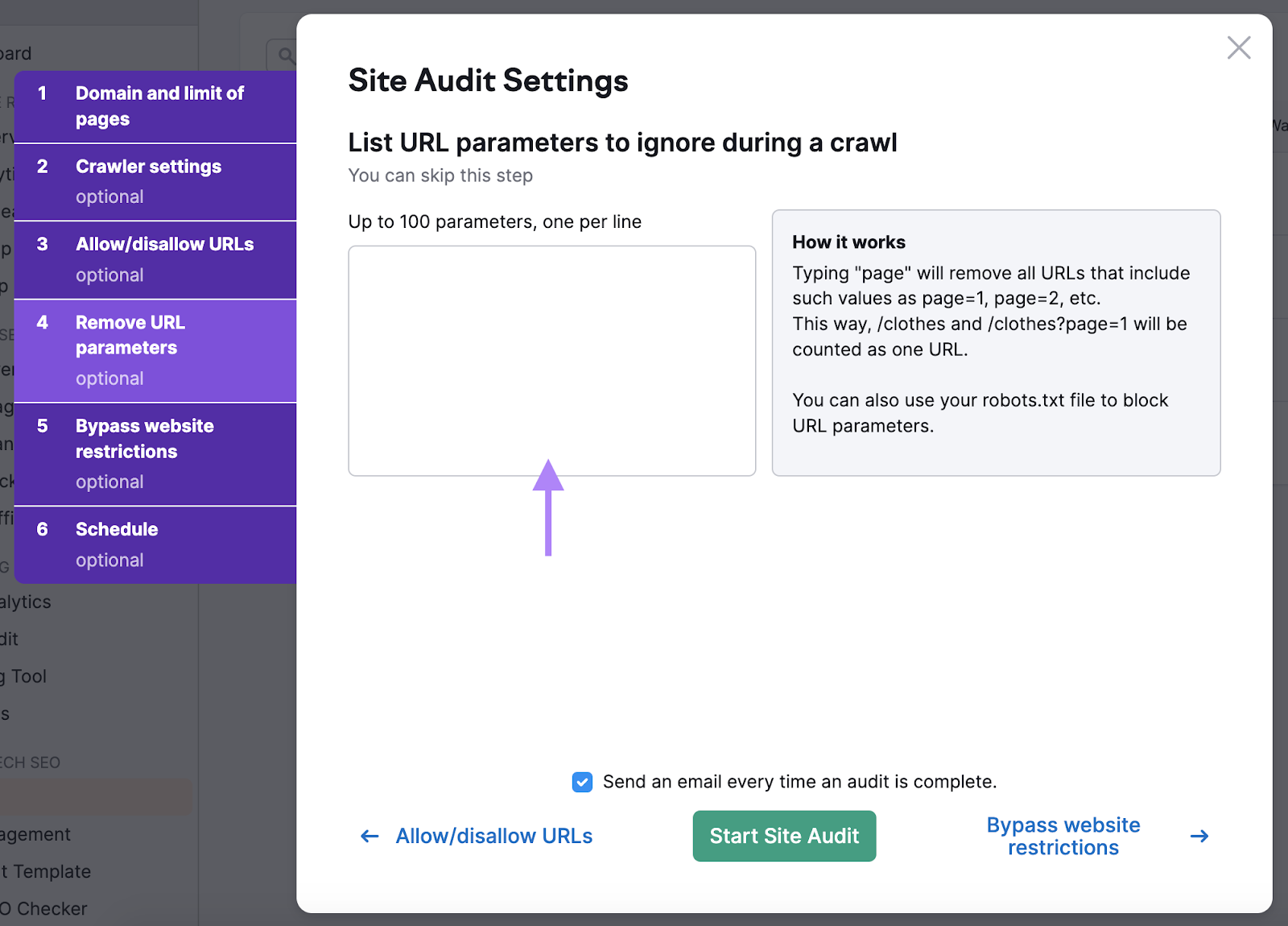

Eliminar parámetros de URL

Eliminar parámetros URL garantiza que los robots no malgasten el presupuesto de rastreo rastreando la misma página dos veces.

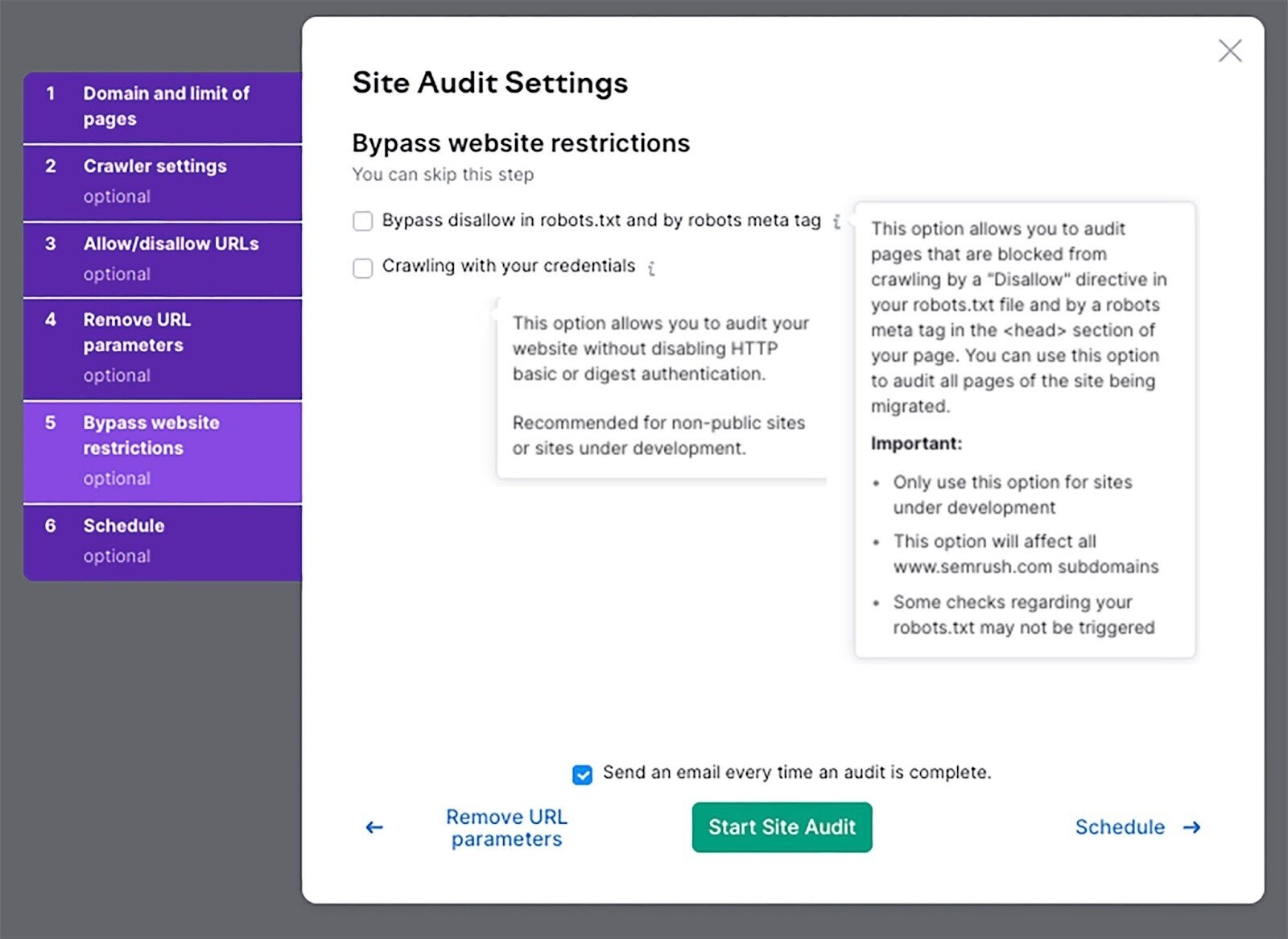

Eludir las restricciones del sitio web

Si tu sitio web aún está en desarrollo, utiliza esta opción para realizar una auditoría.

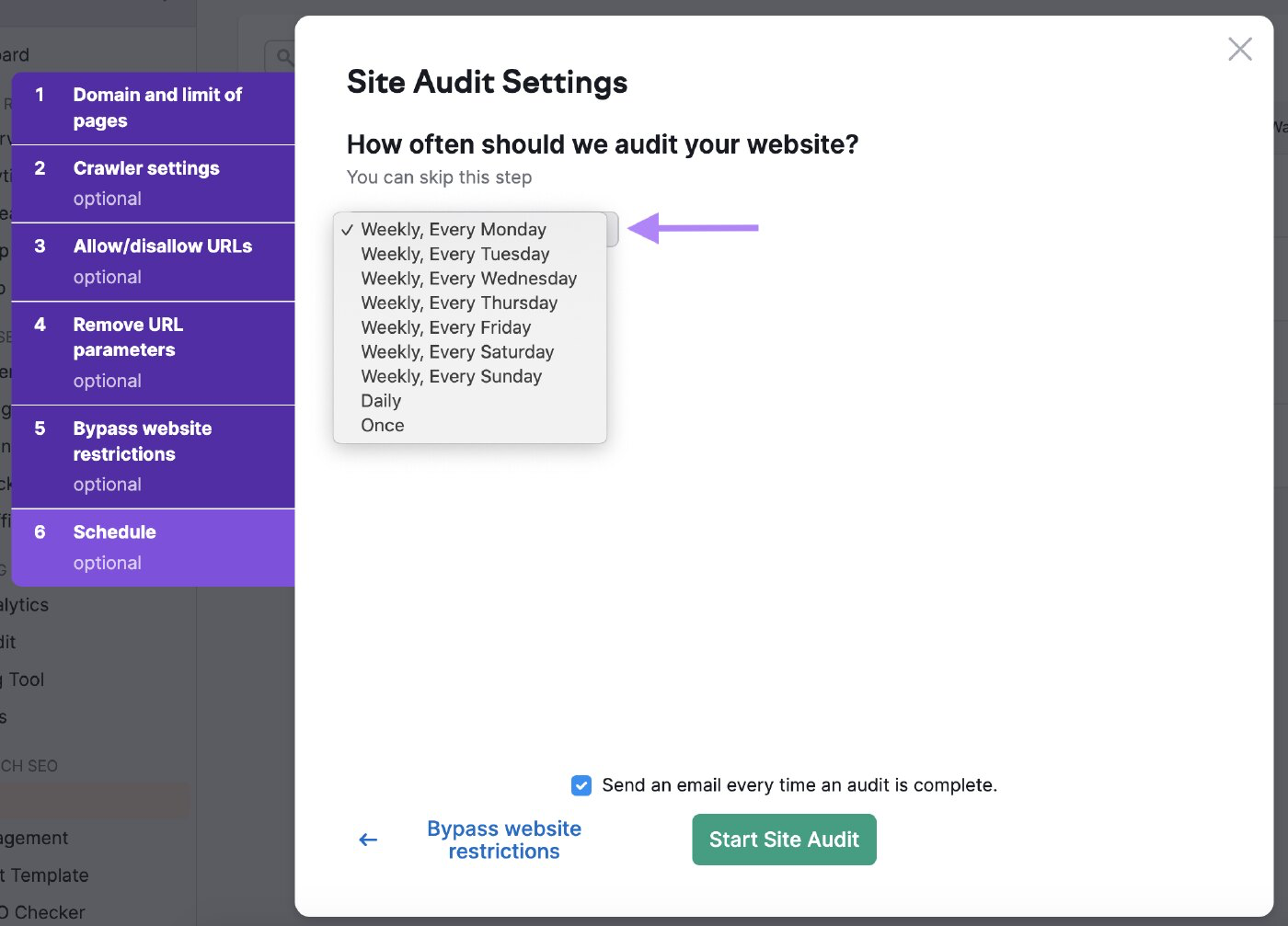

Programa tus auditorías

Puedes programar la frecuencia con la que quieres que el bot audite tu sitio web.

Prográmalo con frecuencia para asegurarte de que la herramienta comprueba regularmente la salud de tu sitio web.

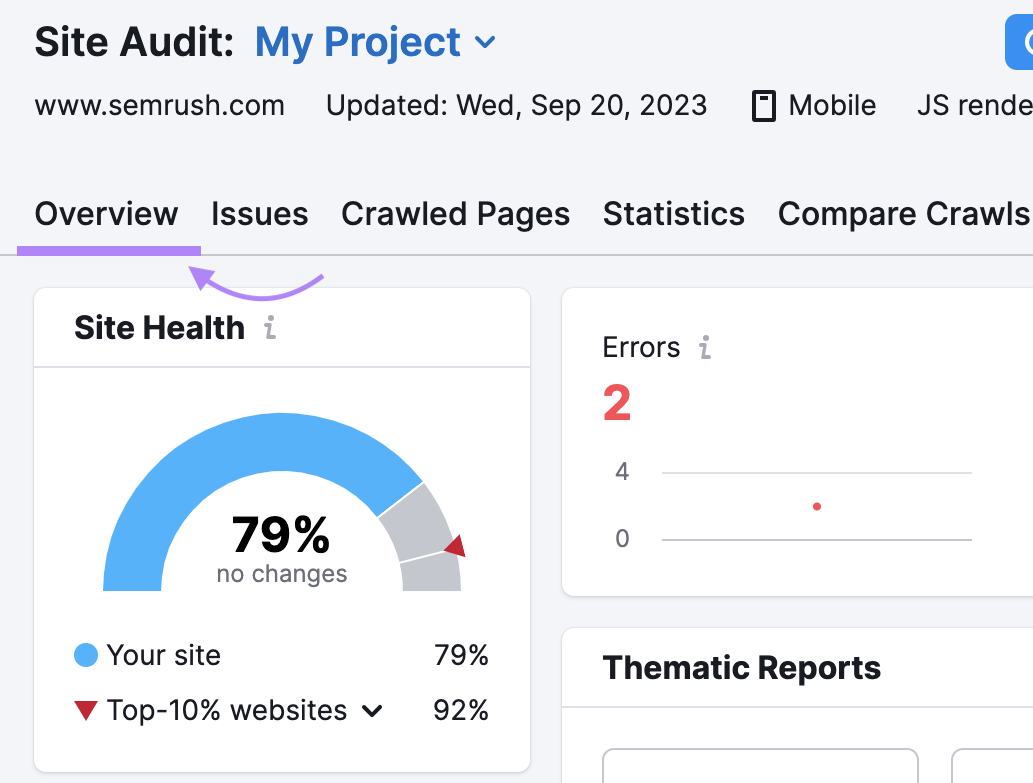

Analiza los resultados

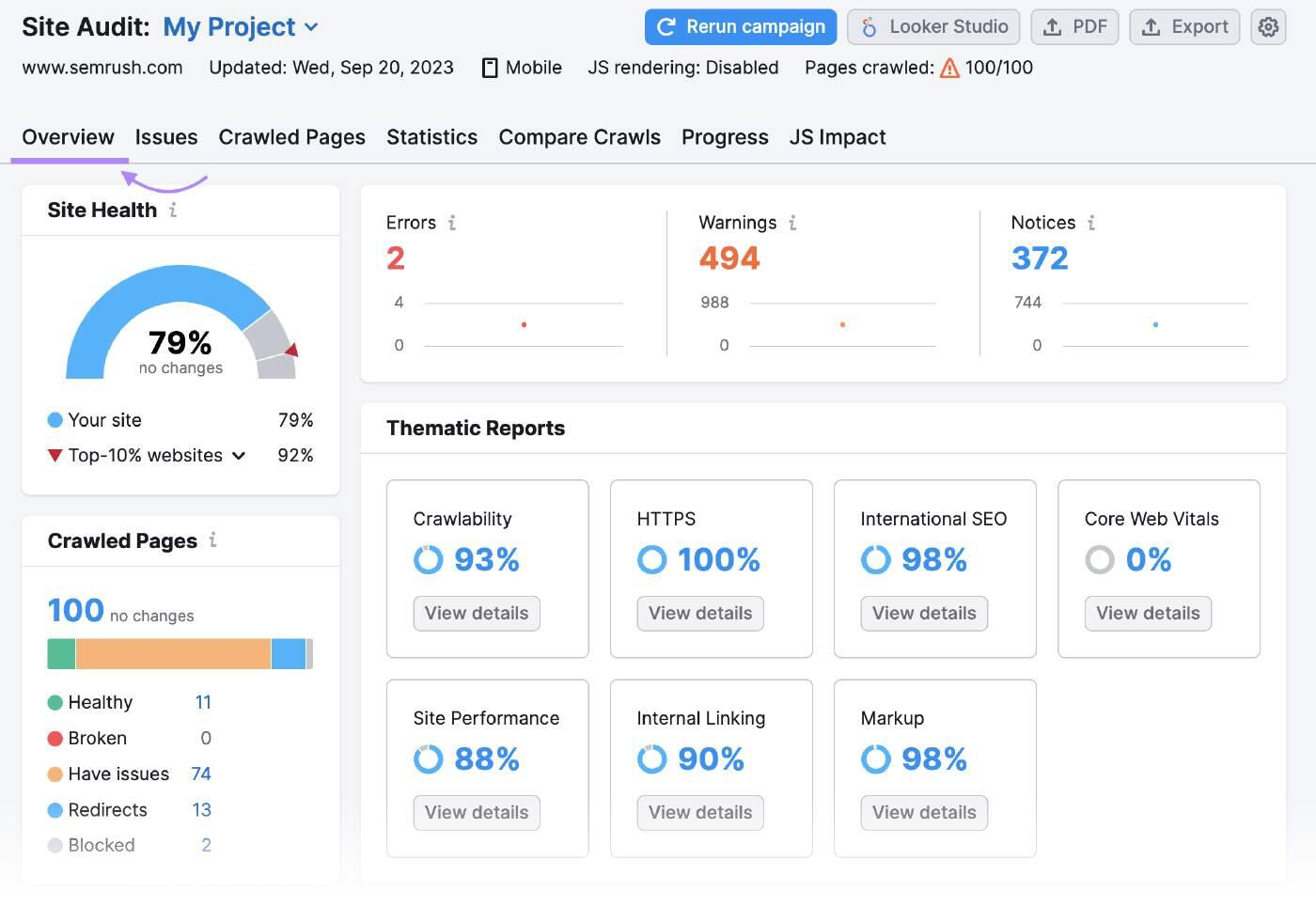

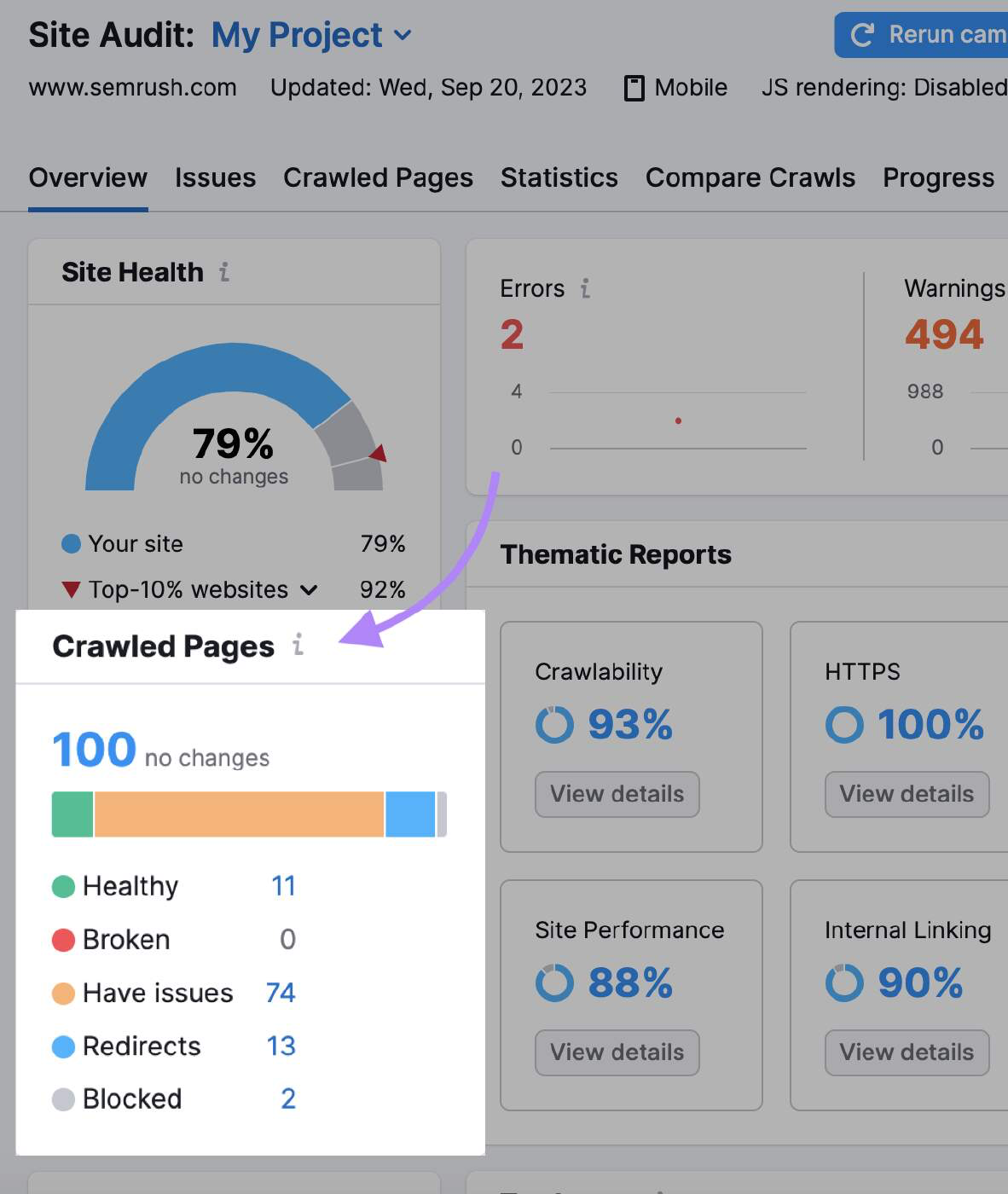

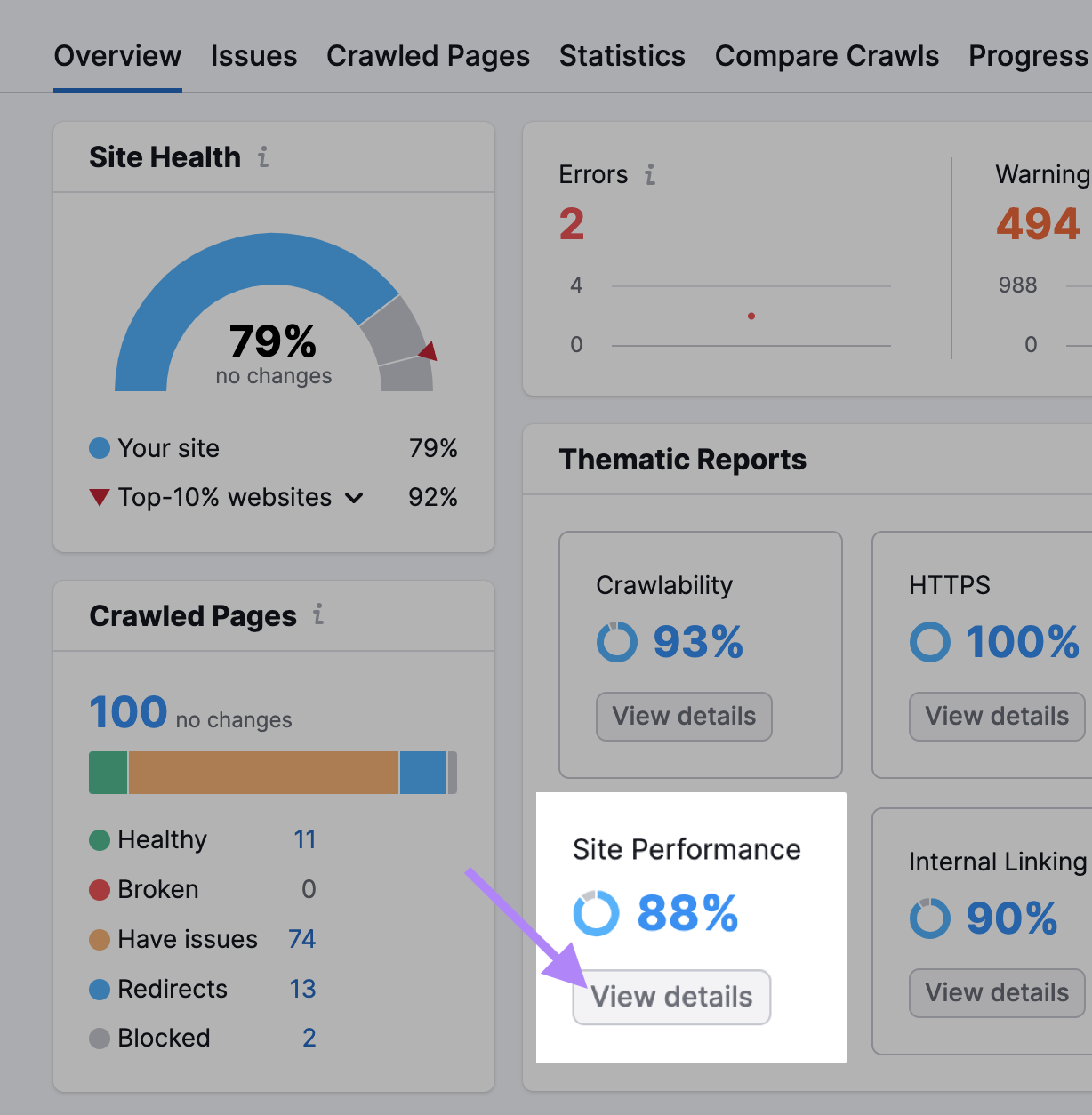

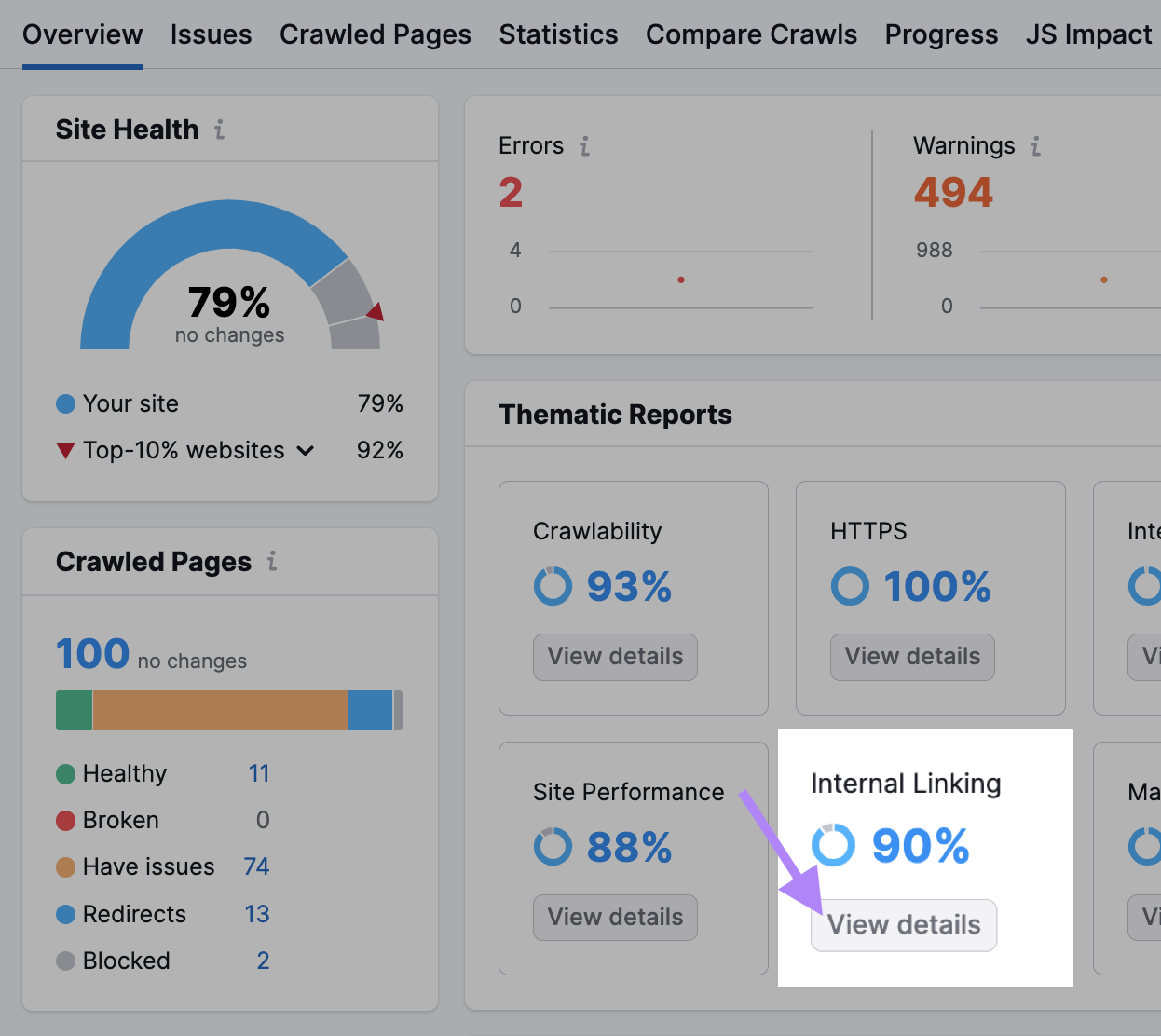

El resumen de la auditoría del sitio resume todos los datos que los robots recogieron durante el rastreo.

"Páginas rastreadas" te dice cuántas páginas estaban "Sanas", "Rotas" y "Tienen problemas".

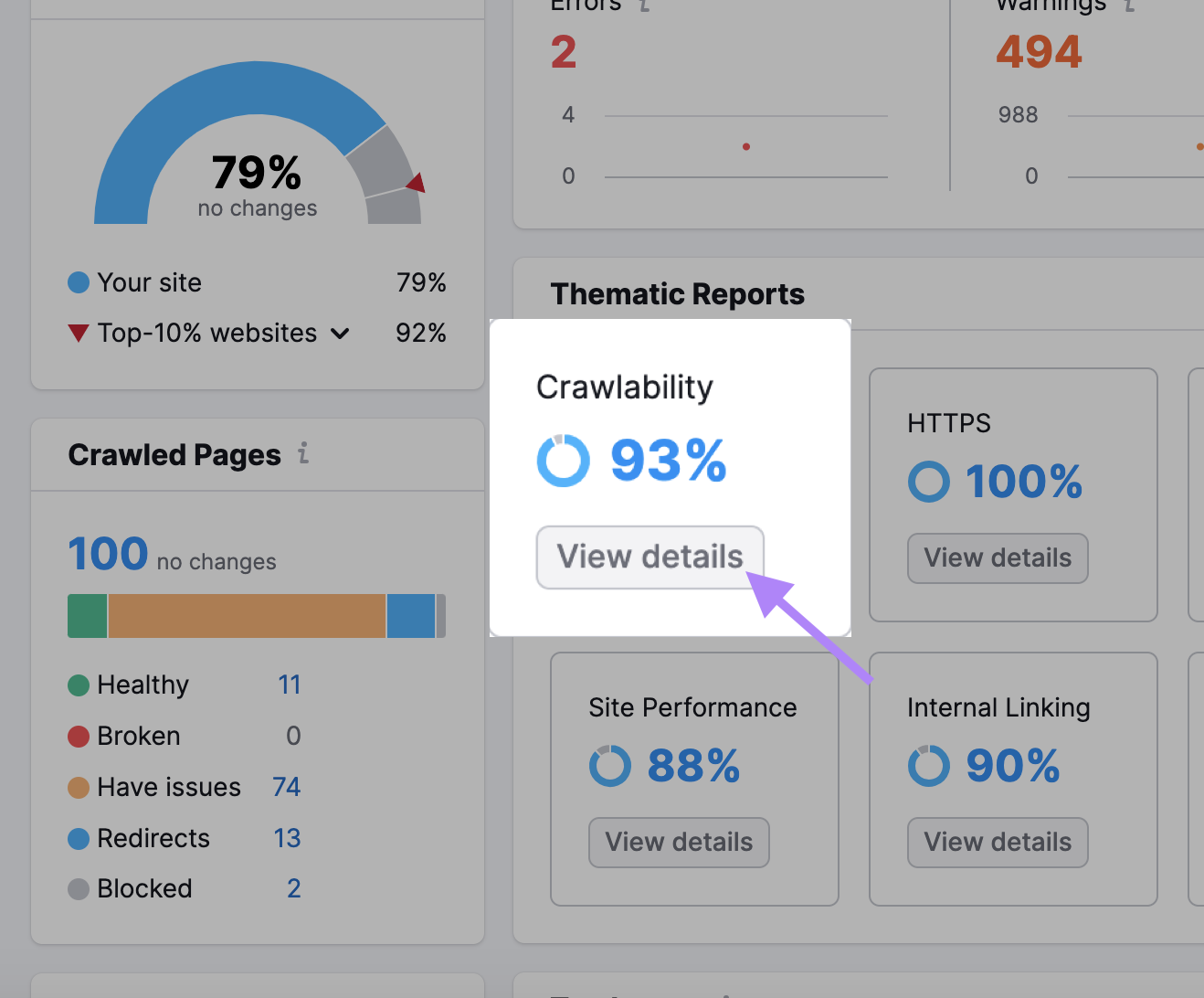

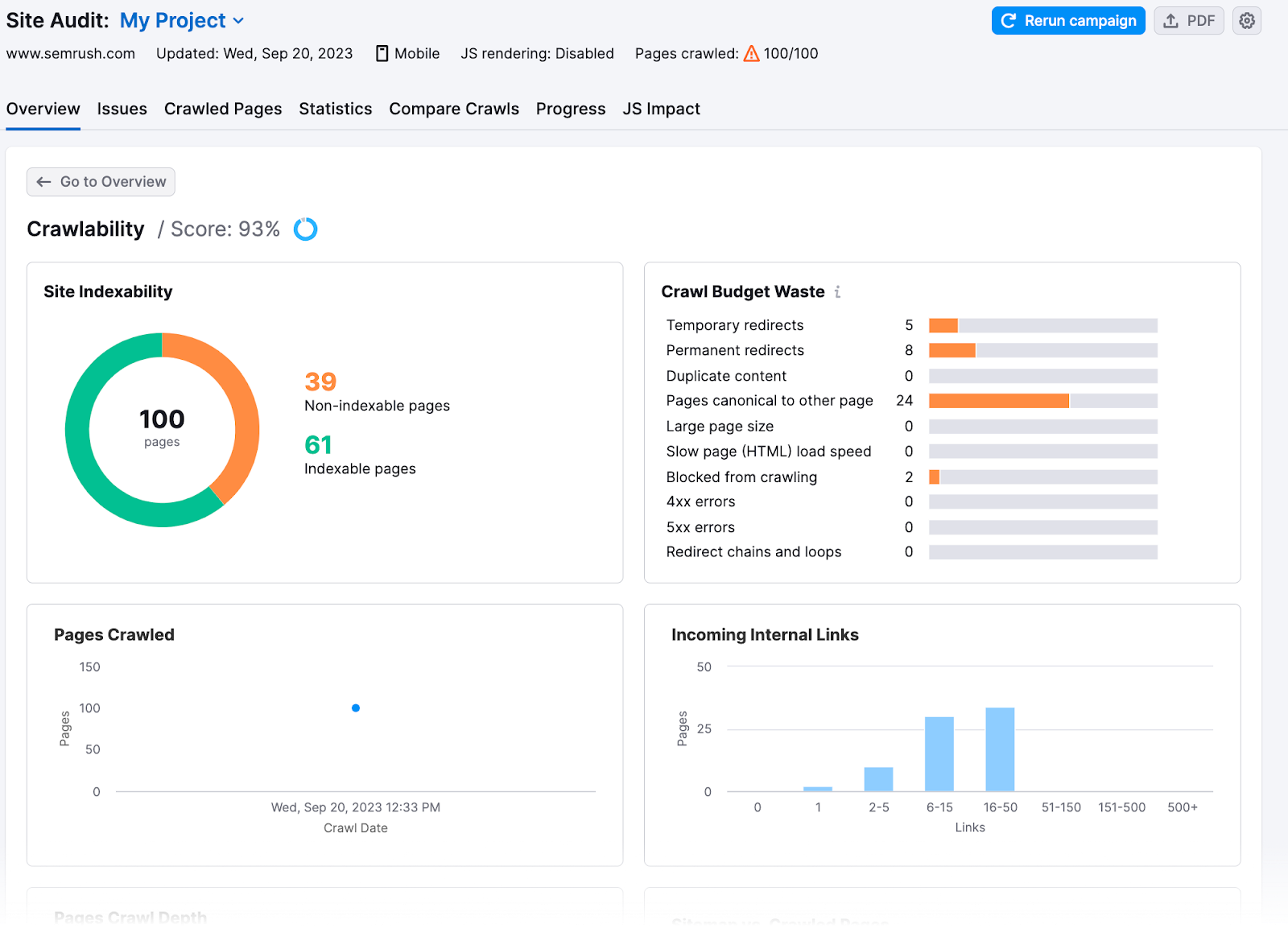

También puedes obtener información más detallada en la sección "Rastreabilidad".

Aquí encontrarás cuánto presupuesto de rastreo de tu sitio se ha malgastado o ha tenido problemas de presupuesto de rastreo.

8 consejos para optimizar el presupuesto de rastreo

Una vez que conozcas los problemas de tu sitio, podrás solucionarlos y maximizar su eficacia de rastreo. He aquí cómo optimizar tu presupuesto de rastreo:

Comprueba la velocidad de tu sitio web

El rastreo de Google está limitado por el ancho de banda, el tiempo y la disponibilidad de recursos de Googlebot. Si el servidor de un sitio web responde más rápidamente a las solicitudes, Google podría rastrear más páginas.

Aumenta la velocidad de tu sitio para mejorar la experiencia del usuario(UX) y ayudar a Google a rastrear tu sitio más rápido.

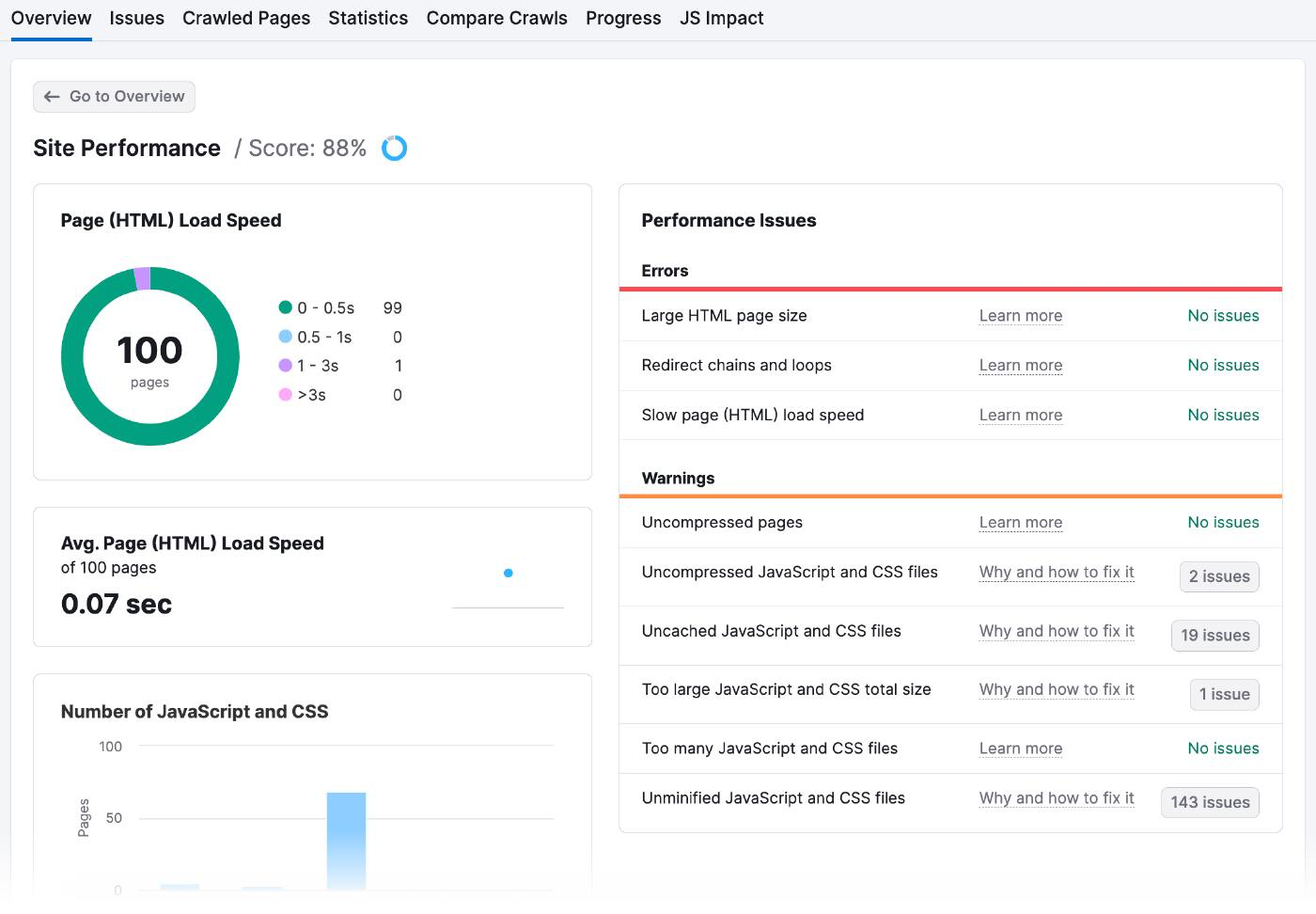

Dirígete a los resultados de Rendimiento del sitio de tu auditoría del sitio para comprobar los tiempos de carga de tus páginas y cualquier problema de rendimiento.

Éste es el aspecto de la página Rendimiento del sitio:

Hay muchas formas de mejorar la velocidad de la página, entre ellas:

- Optimiza tus imágenes: Utiliza herramientas online como Optimizilla para reducir el tamaño de los archivos sin pixelarlos. Asegúrate de que las imágenes tienen el tamaño adecuado y elige el tipo de archivo apropiado (como JPEG, PNG o GIF).

- Minimizar tu código y scripts: Analiza el código de tu sitio web para eliminar todo lo innecesario o redundante. Además, consolida varios archivos en uno solo y utiliza la caché del navegador para almacenar los datos en el ordenador del usuario, de modo que no sea necesario recargarlos cada vez.

- Utilizar una red de distribución de contenidos (CDN): Una CDN es una red de servidores en distintas partes del mundo. Cuando alguien intenta acceder a tu sitio web, la CDN le envía automáticamente el contenido del servidor más cercano, lo que significa que se carga más rápido. Tendrás que registrarte en un servicio CDN como Amazon Cloudfront, subir el contenido de tu sitio web a sus servidores y configurar tu sitio web para que utilice las URL de la CDN en lugar de las tuyas.

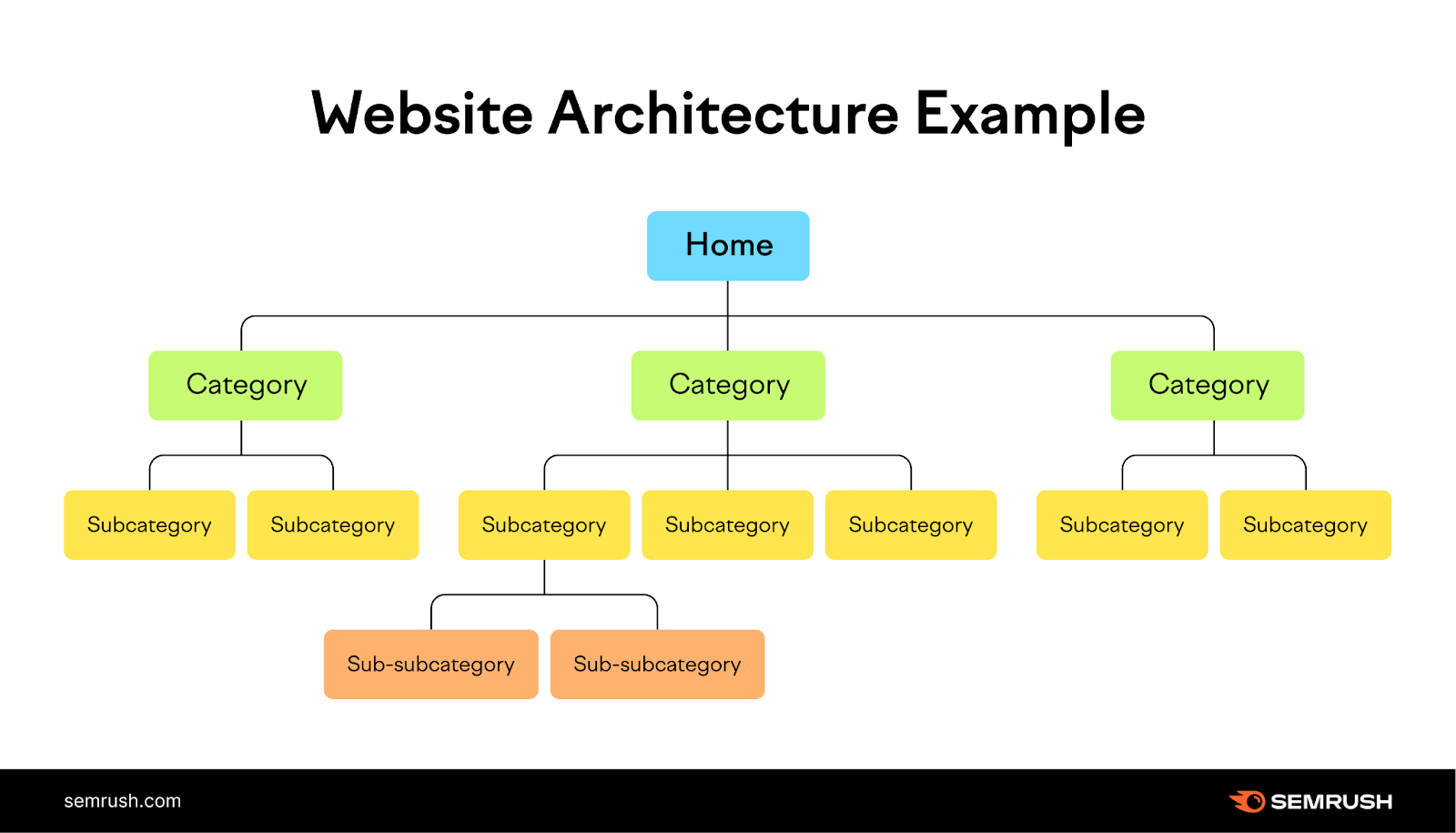

Aumentar los enlaces internos y los sitemaps de página

Si añades una estructura lógica de enlaces internos y un mapa del sitio, los robots sabrán qué páginas indexar.

Los enlaces internos proporcionan una vía natural para que los rastreadores de los motores de búsqueda descubran y clasifiquen nuevas páginas, mientras que los mapas del sitio les ayudan a comprender la estructura y jerarquía de tu contenido.

Imagina tu sitio web como un árbol, con la página de inicio en la parte superior y las ramas representando las diferentes categorías. Cada rama debe conducir a hojas más pequeñas (páginas) relacionadas con ella, creando una estructura clara y lógica para tu sitio web que sea fácil de navegar para los usuarios.

Comprueba la sección Enlaces internos de tu Auditoría del sitio para hacerte una idea de lo bien que lo has hecho.

Cuando dispongas de estos datos, he aquí cómo puedes mejorar tu estructura de enlaces internos:

- Las barras de la Estructura de enlaces internos te indican cuáles de tus páginas son fuertes, mediocres y requieren mejoras. Añade más enlaces internos a las páginas de las dos últimas categorías.

- Crea grupos de temas agrupando páginas relacionadas bajo un mismo tema y enlazándolas entre sí. Digamos que diriges un blog sobre vida sana. Tu página pilar principal podría ser "Vida sana" y tus grupos temáticos podrían ser "Nutrición", "Forma física" y "Salud mental".

- Lo más probable es que Google rastree páginas con muchos enlaces internos. Son las que son nuevas y no tienen suficientes enlaces internos que apunten a ellas las que pueden tener problemas. Por ejemplo, si has añadido recientemente un artículo sobre "Predicciones de marketing para 2024", enlaza a él desde tus páginas más importantes para atraer la atención y el tráfico de Google.

Ocultar las URL que no quieres en los resultados de búsqueda

Marca las páginas de pago, las páginas de aterrizaje de anuncios, las páginas de inicio de sesión y las páginas de agradecimiento como "noindex" para que no aparezcan en los resultados de los motores de búsqueda. Al igual que otras metaetiquetas, la etiqueta "noindex" va en la cabecera <de una página web>.

Esta etiqueta es especialmente útil para páginas duplicadas u otras páginas que quieras mantener privadas.

Aunque los robots seguirán rastreando estas páginas para ver la etiqueta, tomarán nota y limitarán su rastreo en el futuro.

Para indicar a los motores de búsqueda que no indexen una página concreta, utiliza las metaetiquetas robots con un atributo "noindex".

Coloca la siguiente etiqueta en la cabecera <> de tu página:

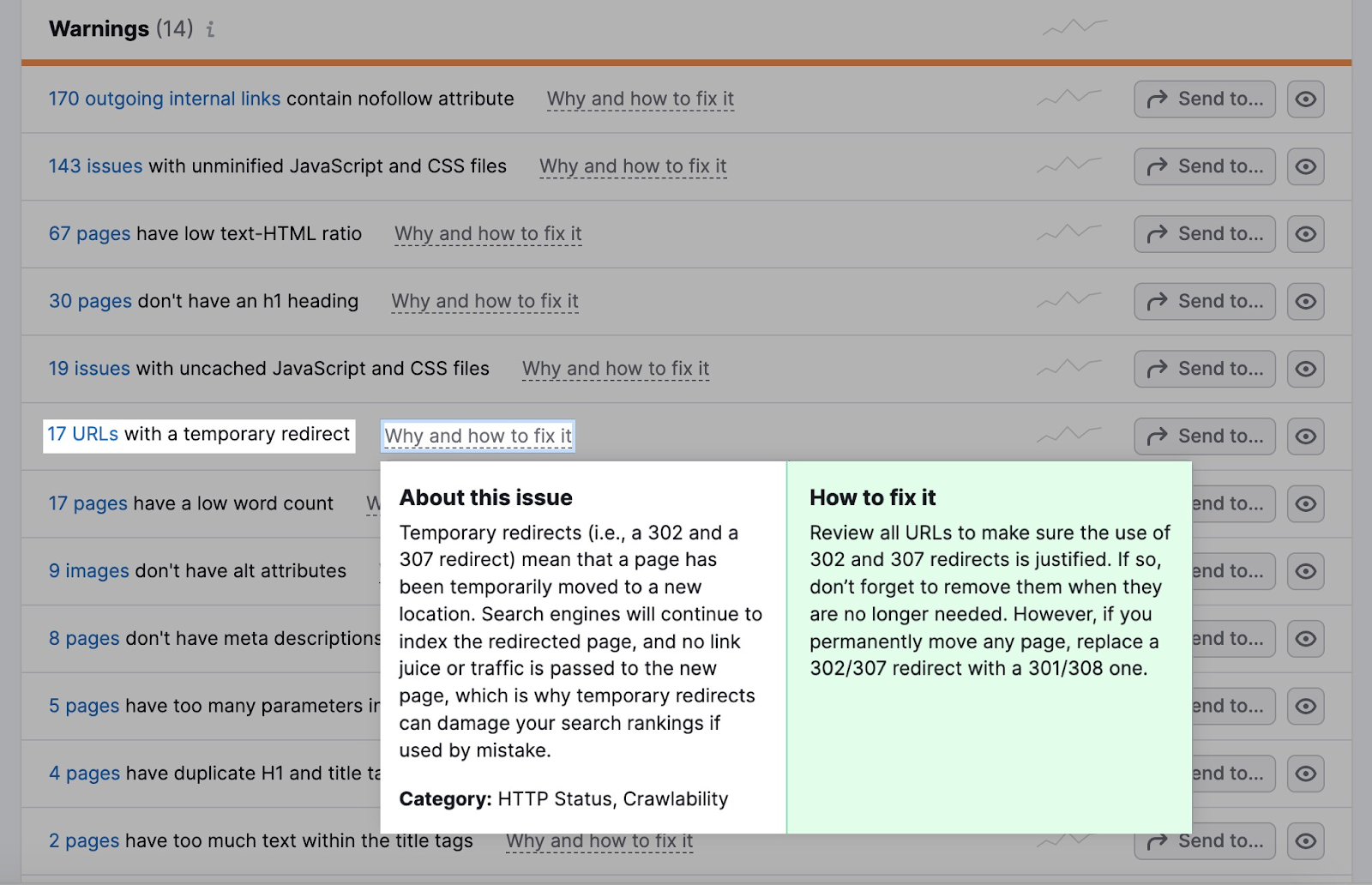

<meta name="robots" content="noindex">Reducir las redirecciones

Los redireccionamientos envían automáticamente a los robots de una página web a otra. Si el bot visita una página que se ha movido o eliminado, la redirección le lleva a la nueva ubicación de la página o a una página que explica por qué la página original ya no está disponible.

Los redireccionamientos requieren más recursos del bot, ya que visita más páginas de las necesarias.

Ve a la pestaña Cuestiones de tu Auditoría del Sitio.

La sección Advertencias te dirá cuántas URL tienen una redirección temporal.

La mayoría de los navegadores seguirán un máximo de cinco cadenas de redireccionamiento en un rastreo.

Si utilizas redireccionamientos, asegúrate de que sean lógicos.

Supongamos que un sitio web de deportes tiene un artículo sobre un partido de fútbol del año pasado con la URL "ejemplo.com/partido-de-fútbol-2022".

Sin embargo, el partido de este año tiene una URL diferente: "ejemplo.com/partido-de-fútbol-2023".

Para evitar confusiones, el sitio web puede establecer una redirección para que cualquiera que intente acceder a "ejemplo.com/partido-de-fútbol-2022" sea redirigido automáticamente a "ejemplo.com/partido-de-fútbol-2023".

Esta redirección sería lógica.

Por otro lado, el sitio web podría tener múltiples redireccionamientos innecesarios, como redirigir de "ejemplo.com/partido-de-fútbol-2022" a "ejemplo.com/partido-de-fútbol-recaps" y luego a "ejemplo.com/partido-de-fútbol-2023".

Eso crearía una cadena de redirecciones que malgastaría recursos y podría perjudicar la eficacia de rastreo del sitio web.

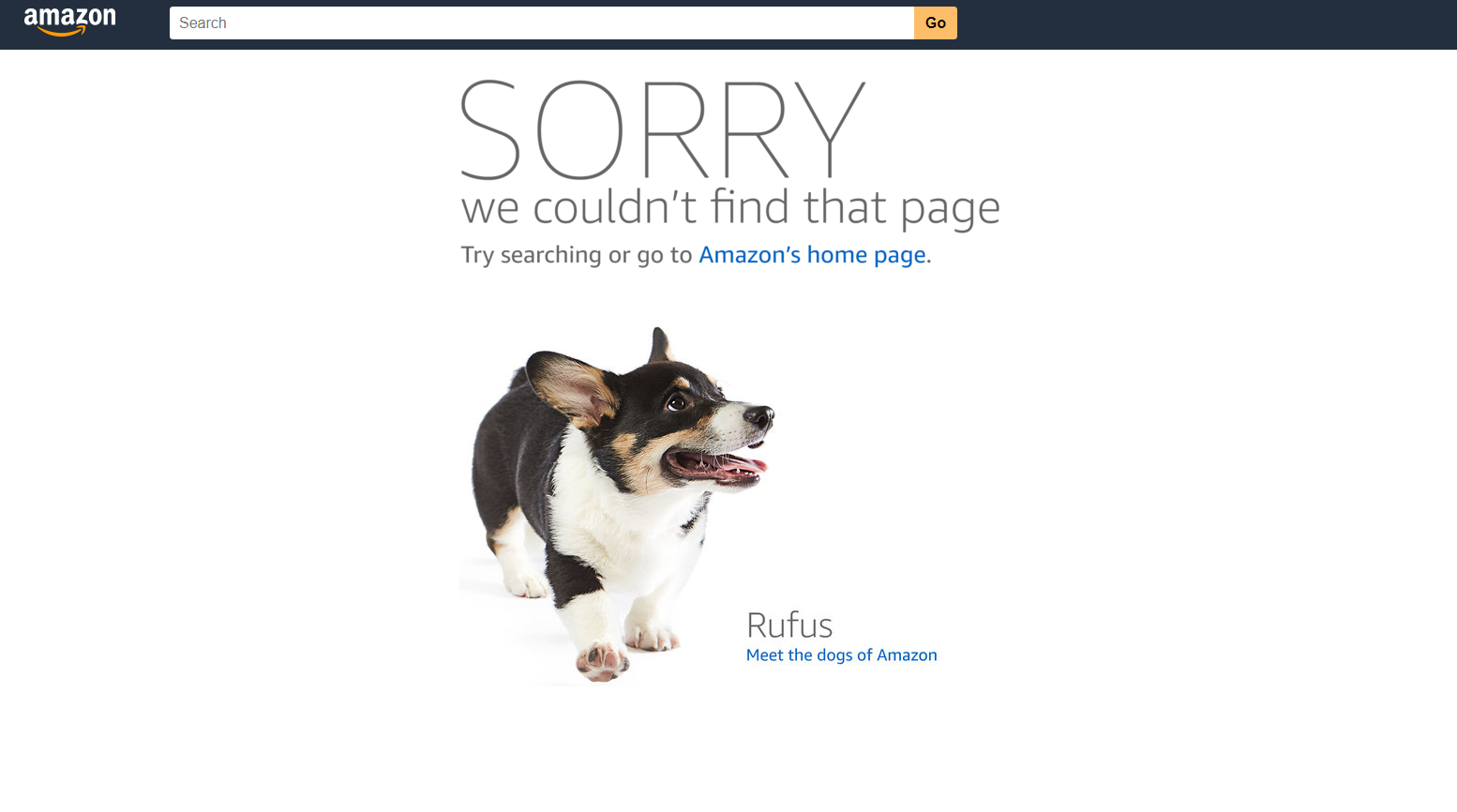

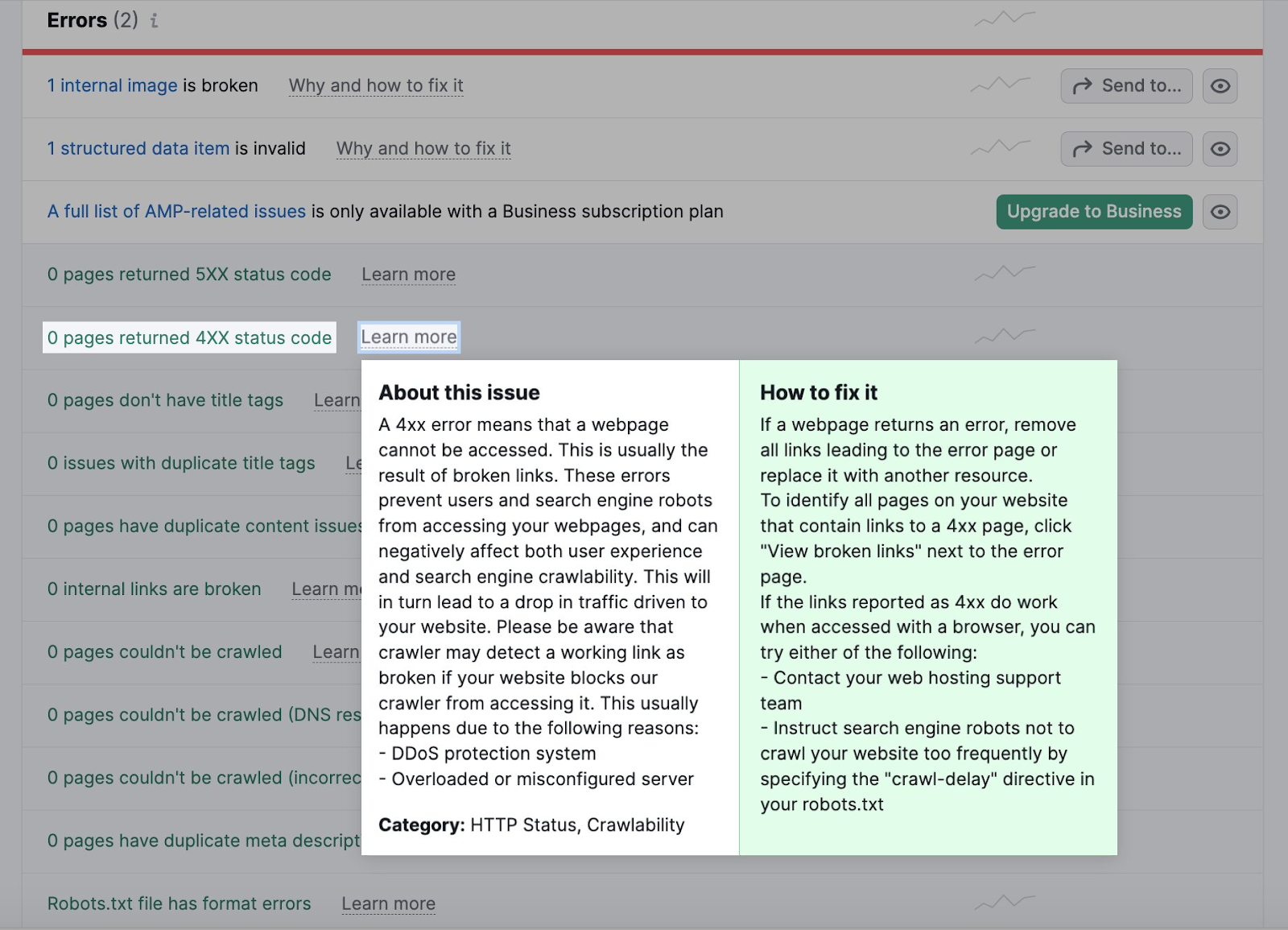

Arreglar enlaces rotos

Los enlaces rotos son páginas a las que los robots no pueden acceder. Perjudican tu rastreabilidad y la experiencia del usuario.

Cuando los robots no pueden acceder a una página, no pueden rastrearla e indexarla. Demasiados de estos errores ralentizan el proceso de rastreo y se comen tu presupuesto de rastreo.

Un error 404 en Amazon, por ejemplo, tiene este aspecto.

Puedes identificar los enlaces rotos como errores 4xx en la pestaña Problemas de tu Auditoría del Sitio.

Haz clic en el número de páginas para comprobar si están rotas. A continuación, sustituye todos los enlaces que lleven a la página rota por otra página.

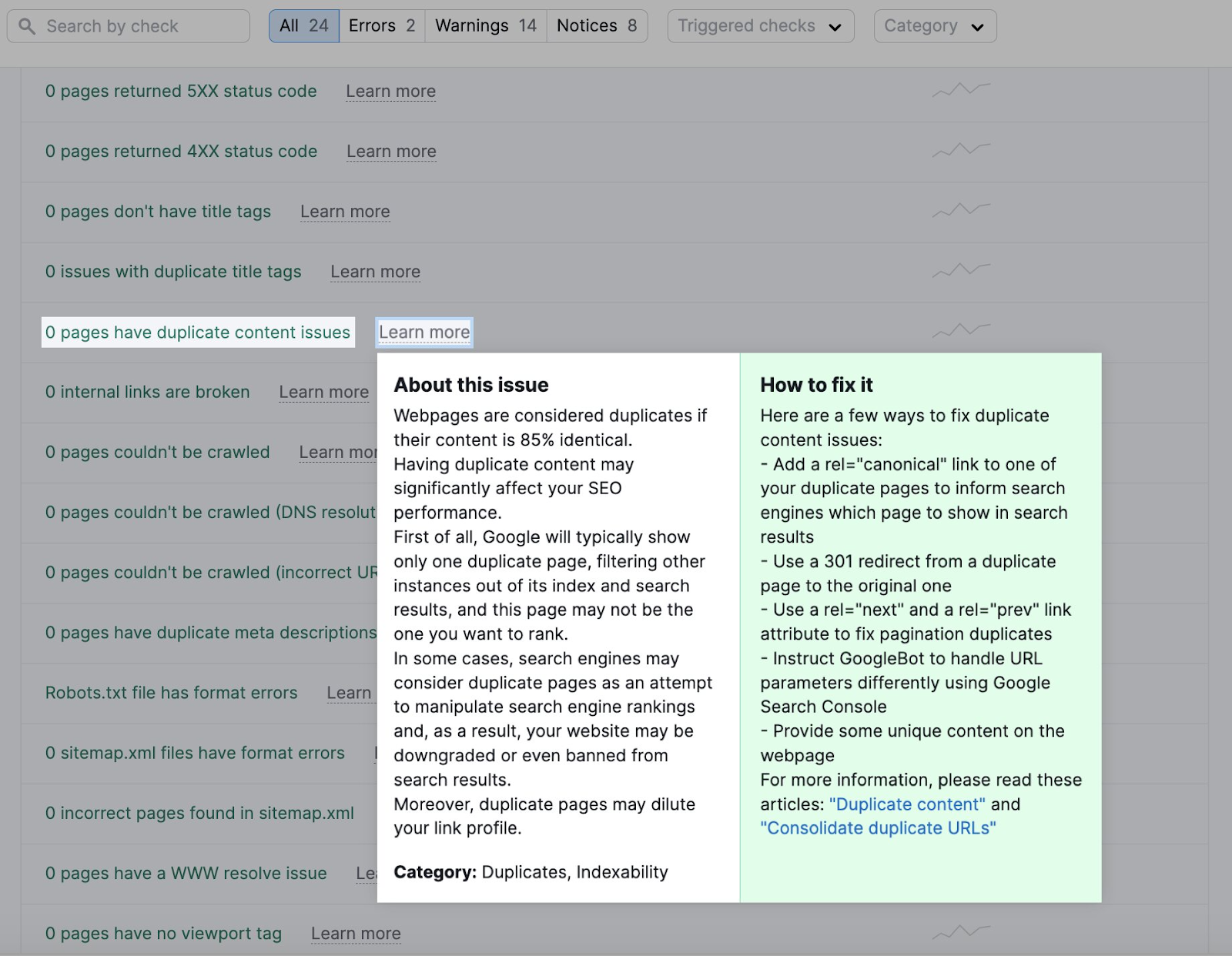

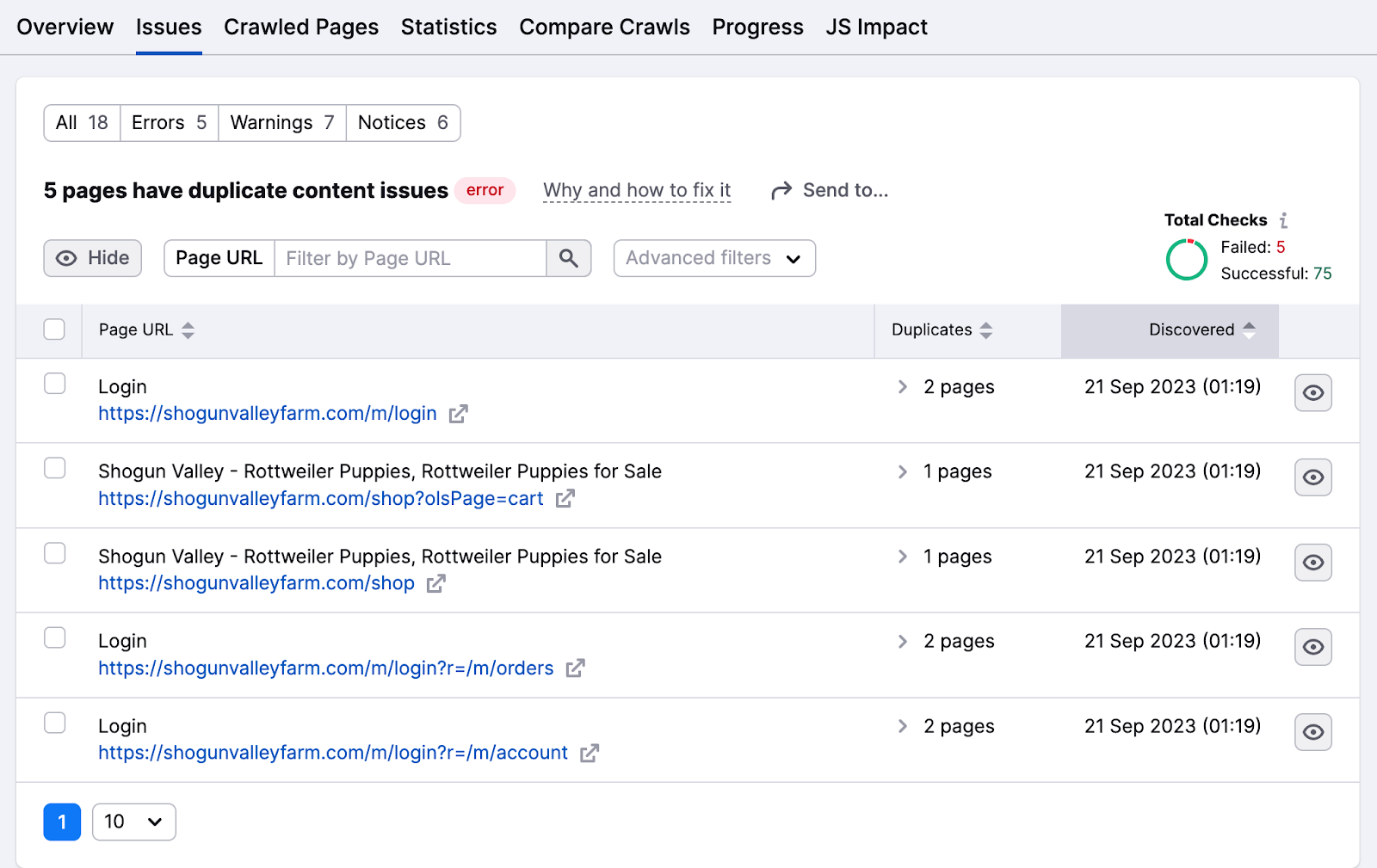

Elimina el contenido duplicado

Los robots consideran duplicadas las páginas web si el contenido es idéntico en un 85%. Reduce el contenido duplicado para evitar que los robots se confundan y rastreen la misma página varias veces, perdiendo tiempo y recursos.

El contenido duplicado también afecta a la indexación, ya que los motores de búsqueda pueden considerarlo una táctica de manipulación.

La pestaña Problemas destaca cualquier problema de contenido duplicado.

Haz clic en el número de página para consultar la lista de páginas con estos problemas.

Algunas formas de solucionar los problemas de contenido duplicado son:

- Haz que el contenido sea único organizándolo en un grupo temático o asignándole una palabra clave de enfoque

- Añade la etiqueta canónica "rel=canonical" en el código HTML de una de estas páginas para indicar a Google qué página quieres que aparezca en los resultados de búsqueda

- Añade una redirección 301 de la página duplicada a la original (no es la mejor idea para reducir las redirecciones)

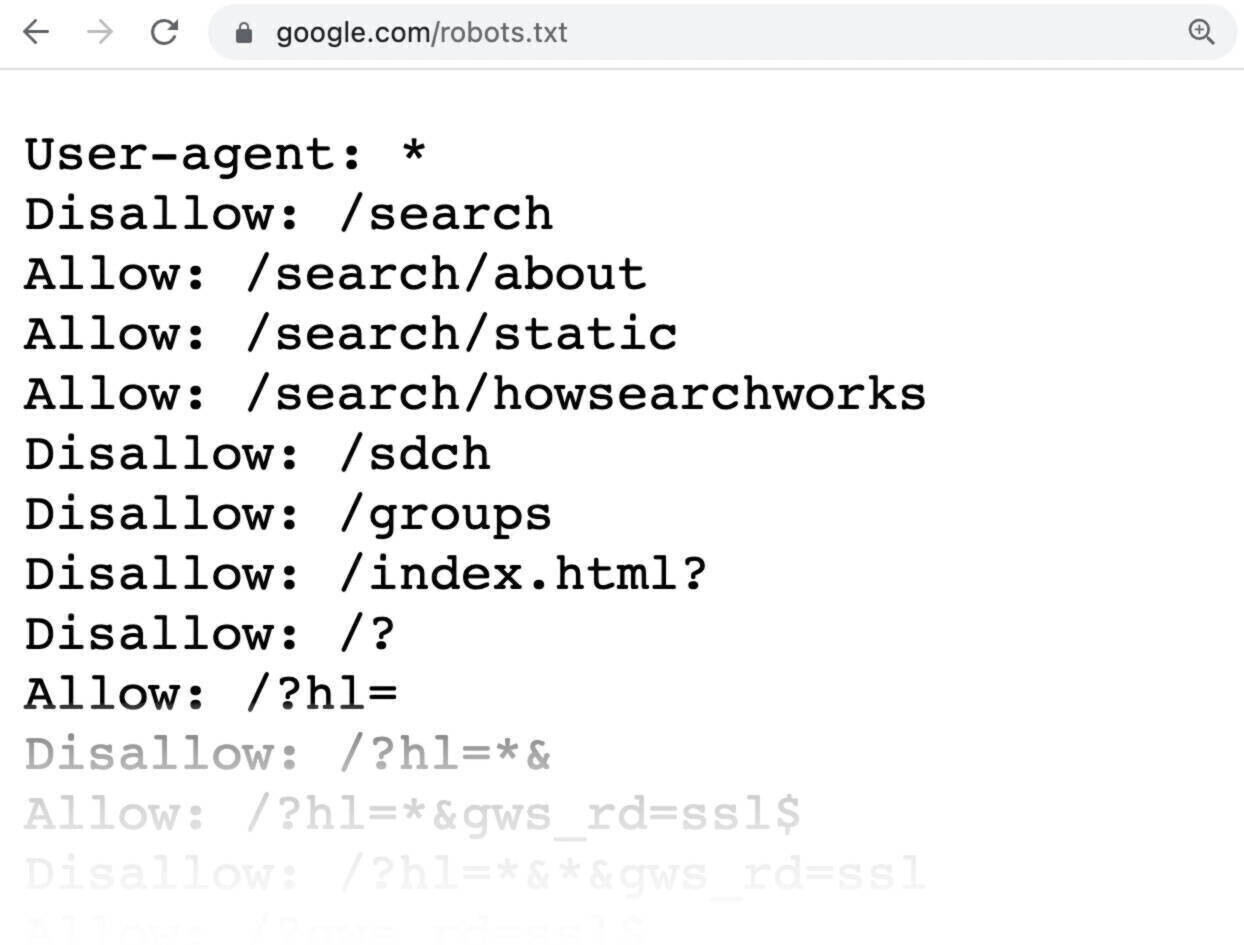

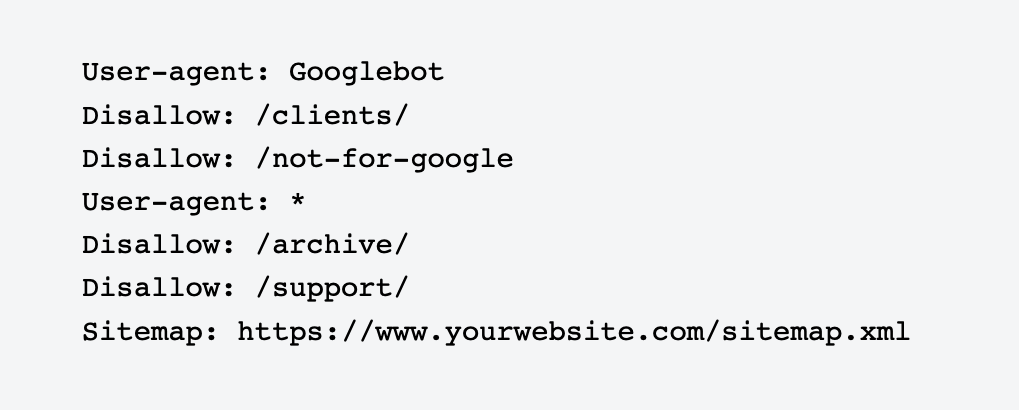

Utiliza Robots.txt

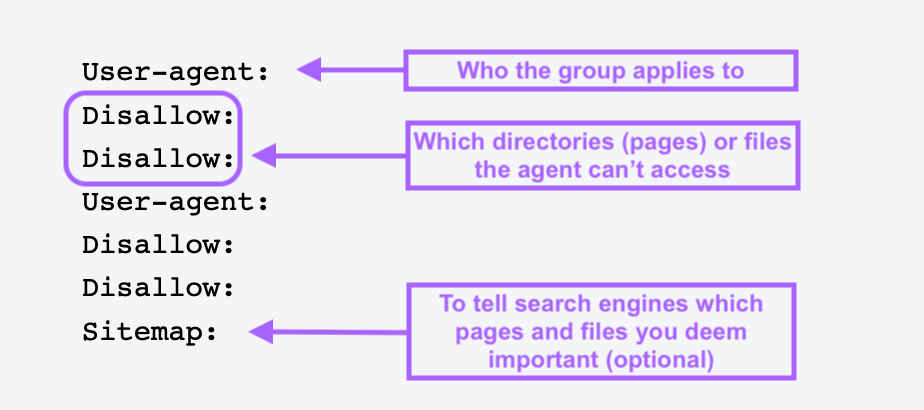

Un archivo robots.txt es un archivo de texto que colocas en el directorio raíz de tu sitio web para indicar a los robots de los motores de búsqueda qué páginas o secciones del sitio no deben rastrear ni indexar.

Los archivos Robots.txt te ayudan a bloquear páginas sin importancia o privadas, como las páginas de inicio de sesión. No quieres que los robots indexen estas páginas y malgasten sus recursos, así que es mejor decirles lo que tienen que hacer.

Este es el aspecto de un simple archivo robots.txt:

Todas las páginas después de No permitir especifica las páginas que no quieres que se indexen.

Para crear un archivo robots.txt, utiliza una herramienta generadora de robots.txt. También puedes hacer uno tú mismo.

Primero abre un documento .txt con cualquier editor de texto o navegador web y dale al documento el nombre robots.txt.

A continuación, añade directivas, que son varias líneas de instrucciones.

Cuando tengas un archivo robots.txt, guárdalo y súbelo a tu sitio. El proceso de carga depende de tu alojamiento web y de la estructura de archivos del sitio.

Ponte en contacto con tu proveedor de alojamiento o busca ayuda en Internet sobre cómo hacerlo. Por ejemplo, busca "subir archivo robots.txt a Shopify" para obtener instrucciones específicas.

Evita las páginas huérfanas

Las páginas huérfanas no tienen ningún enlace interno o externo que apunte a ellas. Estas páginas pueden ser difíciles de encontrar para los rastreadores, por lo que es importante enlazarlas desde otras áreas de tu sitio web.

Una vez que encuentres la lista, enlaza a estas páginas desde otros dominios de alta autoridad de tu sitio web.

También puedes enlazar entradas de blog relacionadas, páginas de productos y páginas de aterrizaje de categorías para facilitar que los rastreadores las encuentren.

Maximiza tu presupuesto de rastreo con Semrush

Aunque Google suele rastrear fácilmente los sitios pequeños, los sitios web más grandes y complejos deben adoptar un enfoque proactivo para gestionar su rendimiento en las búsquedas.

Esto significa supervisar y optimizar regularmente diversos aspectos técnicos de un sitio para garantizar que siga siendo accesible, bien estructurado y muy visible.

Sea cual sea el tamaño de tu empresa, utiliza la herramienta Auditoría del sitio de Semrush para evaluar la salud del sitio web, optimizar la rastreabilidad y corregir errores antes de que causen daños. De este modo, tu sitio seguirá siendo un actor fuerte en las SERP.