¿Qué es lo que define a los tests A/B que hace que debamos darles su merecida cuota de importancia?

La aparente sencillez del concepto de los Tests A/B, la facilidad y rapidez de implementación y los sorprendentes resultados de los casos de éxito más conocidos pueden hacer que muchas veces los ejecutemos sin pararnos a pensar lo suficiente en las decisiones y condiciones que definirán el curso de los tests.

Y ésto puede llevarnos al fracaso de los resultados y a frustrarnos para seguir utilizando esta herramienta.

Sin embargo, si conocemos en detalle el alcance y capacidad de los Tests A/B, las decisiones que debemos tomar durante la fase preparatoria previa a su ejecución y las consideraciones relevantes para analizar sus resultados, aumentaremos sus posibilidades de éxito.

Sin olvidar que de los resultados negativos también se pueden extraer enseñanzas para el futuro.

En este artículo, repasaremos los conceptos más importantes de los Tests A/B en un contexto que facilite su comprensión y alcance y también veremos qué debemos tener en cuenta para llevarlos a cabo con éxito.

Finalmente, abordaremos un caso práctico de cómo implantarlos con Google Analytics en un gestor de contenidos tan popular como WordPress.

Definiendo el problema: ¿Cómo aumentar las conversiones?

Imagínate que tienes una Landing Page con un promedio de 10.000 visitas mensuales y una tasa de conversión del 1%, es decir, 100 usuarios completan una acción que marca un objetivo en tu proyecto.

Sin entrar en evaluar si éstos son valores buenos o malos (lo que sería tema de debate para otro foro), ¿cómo podrías duplicarel número de conversiones?

Es decir, nos centramos en un paso intermedio del embudo de ventas:

La primera, quizás por obvia, solución en que solemos pensar es en aumentar el número de visitas: “a más visitas, mayor número de conversiones” parece una afirmación razonable.

Sin embargo, esta solución parte de los dos siguientes supuestos:

- Que el índice de conversión no varía. Dado que no cambiamos la Landing Page, tendemos a pensar que el índice de conversión tampoco cambiará significativamente.

- Que la proporción de visitas cualificadas, dentro del aumento de visitas que hemos recibido, mantendrá una proporción similar a las que hemos tenido anteriormente.

La dura realidad es que no tenemos forma de garantizar que estos factores se mantengan más o menos constantes.

Dicho de otra forma, aunque consigamos duplicar las visitas, probablemente el aumento del porcentaje de visitas cualificadas y la incidencia en la tasa de conversión sean menores, con lo que finalmente no alcancemos el efecto deseado de duplicar el número total de conversiones.

Pero no es éste el principal contratiempo.

Aun suponiendo que consiguiéramos mantener constantes la tasa de conversión y la proporción de visitas cualificadas, para duplicar el número de visitas mensuales deberemos desarrollar y lanzar campañas de promoción y difusión de nuestro sitio web.

Ahora bien, ejecutar estas campañas tienen asociados unos costes en función de cómo las hagamos:

- Campañas de posicionamiento orgánico (SEO), que requieren un seguimiento y una dedicación continuados a lo largo del tiempo y cuyos resultados pueden necesitar varios meses para hacerse patentes.

- Campañas SEM (AdWords o de pago), que requieren una inversión económica mientras dura la campaña y aunque sus resultados ya se pueden observar desde el inicio de ésta, solo persisten mientras se siga manteniendo esta inversión.

Duplicar las visitas no garantiza duplicar las conversiones y, además, puede requerir una inversión importante, sea en tiempo o económica

Pero no nos rindamos todavía.

Veamos ahora la otra pata de la ecuación y hagámonos la siguiente pregunta: ¿y si en vez de aumentar el número de visitas, intentamos aumentar la tasa de conversión?

Identificando lo que puede aumentar la tasa de conversión

En el escenario que habíamos imaginado al principio, con 10.000 visitas y un 1% de tasa de conversión, analizamos la posibilidad de duplicar el número de visitas para duplicar las conversiones totales, pero vimos que incurríamos en algunos inconvenientes.

Disponemos de otra posibilidad de duplicar el número de conversiones si, en vez del número de visitas, nos centramos en duplicar la tasa de conversión.

A poco que busquéis por Internet, encontraréis centenares de recomendaciones y trucos para diseñar Landing Pages que aumenten la tasa de conversión.

Sin embargo, ¿podemos estar seguros que estas técnicas son realmente eficaces para nuestro sitio web y cuánto beneficio nos pueden aportar?

No estoy poniendo en duda la efectividad de estas técnicas, nada más lejos de mi pensamiento, pero no debemos olvidar que no existen “soluciones universales” y que, dentro de las directrices generales que estas recomendaciones marcan, también hay múltiples factores que afectan al alcance de su efectividad.

Podemos tomar como referencia el nicho de mercado en el que nos situamos o el perfil de nuestra audiencia objetivo, por nombrar un par de ellos.

Como primera aproximación para abordar nuestro problema, podríamos pensar en modificar nuestra Landing Page introduciendo alguna de estas técnicas o recomendaciones y esperar a ver qué pasa.

Sin embargo, esta opción presenta varios inconvenientes:

- La mayoría de las veces, estas recomendaciones no son específicas en su descripción.

Más bien, se refieren a elementos generales cuyo efecto en la tasa conversión debemos evaluar y valorar para las características concretas de nuestra web.

Por ejemplo, aspectos como la elección de uno u otro color para los botones, el tipo de letra de la llamada de acción o las imágenes utilizadas pueden influir en las conversiones, pero ¿cuál es el color o tipo de letra que mejor funcionaría para “mi” Landing Page?

- Si nos hemos equivocado en la aplicación o selección de una técnica, podemos perder un número significativo de conversiones.

Y, en consecuencia, tener efectos negativos en nuestros beneficios.

Teniendo en cuenta que para observar el efecto de un cambio puede ser necesario un número elevado de visitas, el coste por pérdida de beneficios puede ser demasiado alto para nuestros objetivos.

- Los resultados pueden verse influenciados por factores externos o estacionales.

Un ejemplo muy claro sería si nuestros productos o servicios están relacionados con actividades de ocio que, muy probablemente, tengan mayor tirón comercial en fechas cercanas a periodos vacacionales.

Si cambiamos nuestra Landing Page en esas fechas, no tendríamos forma de asegurar si el aumento de conversiones es debido a dichos cambios o a la proximidad de las vacaciones.

Ante esta encrucijada, ¿qué podríamos hacer para, por un lado, poder “experimentar” diversas alternativas para mejorar la tasa de conversión pero, al mismo tiempo, reducir el perjuicio de cambios inadecuados en la Landing Page o el efecto de influencias externas?

Afortunadamente, disponemos de una herramienta, de fácil implementación y ejecución, que puede ayudarnos a responder a esta pregunta: los tests A/B.

Los Tests A/B ayudan a identificar qué cambios en una página web pueden mejorar el valor de una métrica-objetivo

Hasta ahora nos hemos marcado como objetivo aumentar la tasa de conversión, como ejemplo para comprender mejor el concepto de tests A/B, ya que se trata de una métrica generalmente muy bien comprendida y poco propensa a ambigüedades.

Sin embargo, también podemos utilizar los tests A/B para analizar cualquier otra métrica, como la tasa de rebote o el tiempo de permanencia en página.

En definitiva, toda aquella métrica que queráis optimizar y que podáis analizar a partir de modificaciones muy concretas dentro de una página.

¿En qué consisten los Tests A/B?

A priori, no podemos saber con certeza qué cambios de una Landing Page propiciarían un aumento de las conversiones, así que necesitamos experimentar para encontrar la mejor combinación, pero reduciendo el riesgo de perder beneficios u obtener resultados no concluyentes debidos a influencias externas.

En este sentido, los tests A/B nos permiten comparar el comportamiento de dos versiones de una misma página, normalmente una Landing Page, que difieran en un único elemento y cuyo objetivo es evaluar el impacto que ese elemento tiene en los usuarios visitantes, medido por la métrica que definamos, durante un determinado periodo de tiempo.

Durante la ejecución del test, los visitantes visualizan aleatoriamente una u otra versión de la página, de forma que, al final del experimento, el total de visitantes se repartirán en partes iguales entre ambas versiones.

Se podría ver como si, cuando un usuario solicita la página, se echara una moneda al aire y, según salga cara o cruz, se le muestra una u otra versión.

Con este método, resolvemos dos de los problemas que identificamos anteriormente, cuando nos planteamos modificar la Landing Page sin ninguna otra consideración:

- Dado que las dos versiones de la página coexisten, eliminamos la influencia de cualquier factor externo o estacional en el análisis de los resultados, puesto que ambas son afectadas por igual.

- En caso de que el cambio afecte negativamente a la tasa de conversión, el impacto en la pérdida de nuestros beneficios queda reducido a la mitad.

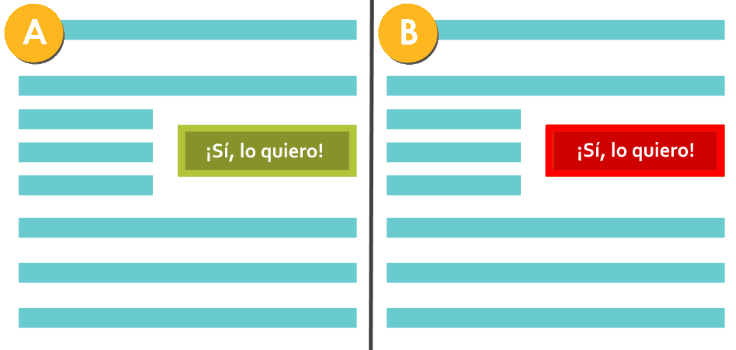

El ejemplo clásico en los tests A/B hace referencia al color de los botones en las llamadas a la acción, utilizando un color en la página original (versión "A" o página de control) y otro color en la variación (versión "B") de la página:

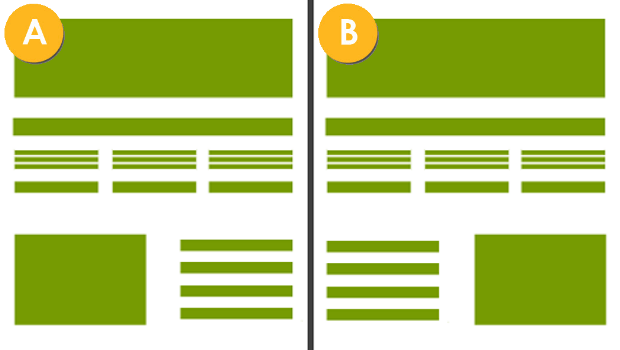

Sin embargo, no debemos limitar estos test a cambios tan simples como variaciones de colores, de tipos de letras o incluso de titulares e imágenes, sino también cambios estructurales en la disposición de diferentes elementos de la página, como la longitud de un artículo o la posición de un banner publicitario:

No tengáis miedo de probar cualquier cambio que se os ocurra, pero siempre con la precaución de evitar modificaciones múltiples o radicales que hagan diferenciarse demasiado ambas páginas.

De hacerlo así, no podríamos identificar qué cambio ha producido mayor beneficio o, incluso, puede suceder que los efectos positivos de un cambio sean neutralizados por los efectos negativos de otro y estemos desechando algún cambio que habría sido beneficioso.

Cambies lo que cambies, nunca olvides la máxima de los tests A/B: dos versiones similares de una página, con un único elemento diferente entre ambas

Para que os hagáis una idea de la importancia de ser creativos con los cambios que podemos realizar, observad los dos anuncios siguientes (extraídos de este ejemplo de utilización de mapas de calor), ¿cuál creéis que tiene mayor índice de conversión?:

La información de ambas páginas es idéntica pero, mientras que en una, el bebé nos miraba de frente, en la otra miraba al titular del anuncio... ¡siendo ésta última la que mayor tasa de conversión tenía!

Por tanto, no pongáis límites a vuestra imaginación en cuanto al tipo de cambios que queráis experimentar.

El proceso de ejecución de un test A/B

Como yatenemos claro qué son los tests A/B y lo que podemos hacer a través de ellos, veamos ahora cómo es el proceso que debemos seguir para llevar a cabo un test A/B en nuestro sitio web:

-

Identificar qué páginas web queremos analizar y la métrica que utilizaremos para evaluar el impacto de los cambios que efectuaremos en cada página.

No hay restricciones en el número de tests A/B que queramos ejecutar simultáneamente, siempre y cuando sean sobre distintas páginas web.

Asimismo, cada test puede evaluarse con la métrica que consideremos oportuna, independientemente del resto.

-

Identificar qué elemento de cada página queremos evaluar y cuál será el cambio que haremos.

Sólo puede haber un cambio por página y que afecte solamente a ese único elemento, para asegurar la correcta asignación del impacto en la variación de la métrica a analizar.

-

Crear las correspondientes variaciones de cada página, idénticas a las originales en todos los conceptos excepto en los elementos identificados en el punto anterior.

-

Determinar la duración del experimento, ya sea en número de visitas o por un periodo de tiempo concreto.

En ambos casos, debe ser lo suficientemente grande para recopilar los datos necesarios para el posterior análisis de las métricas.

-

Ejecutar el test, repartiendo las visitas aleatoriamente al 50% entre ambas versiones de cada página.

Y registrando por separado el comportamiento de los usuarios según la métrica que hayamos asociado para esa página.

-

Detener el experimento y analizar las métricas de ambas versiones de cada página para determinar el impacto y alcance del cambio efectuado en la página original.

Esto, una vez hayamos alcanzado el número de visitas o periodo de tiempo establecido como duración del experimento.

-

Un experimento no debe ejecutarse indefinidamente.

Google apoya la realización de tests A/B, pero establece algunas recomendaciones y condiciones de uso.

Dada su importancia, en un apartado posterior veremos con más detalle el posible efecto de los tests A/B sobre el SEO.

Una vez concluido el test A/B, si observas mejores valores para la métrica elegida en la variación de la página, ¡enhorabuena!, has conseguido mejorar tu página web.

Pero no te duermas en los laureles: el proceso no finaliza aquí, sino que te abre la puerta para seguir haciendo más tests A/B.

Esta vez, sobre la nueva versión de la página y así seguir mejorando otros aspectos de ésta, para la misma u otras métricas.

Si, por el contrario, la métrica en la variación ha sido peor, no te apenes, porque has aprendido una importante lección: lo que no atrae o no gusta a tu audiencia.

Y eso, posiblemente, te pueda inspirar otros cambios que sí les atraigan o gusten.

Aunque los resultados de un test A/B no reflejen mejoras en la métrica-objetivo, nos ayudarán a conocer mejor a nuestra audencia.

En este proceso, fíjate que todos los puntos dependen exclusivamente de decisiones nuestras, excepto el punto dedicado a repartir las visitas entre la página de control y su variación.

La realización de esta tarea debe ser implementada en el propio servidor web y, por tanto, requiere una solución técnica, a la que dedicaremos la última sección de este artículo.

¿Qué duración debe tener un test A/B?

Si revisas el punto del proceso de ejecución de un test A/B, sobre la duración del experimento, decía que “debe ser lo suficientemente grande para recopilar los datos necesarios”.

Pero, ¿cuánto es “suficientemente grande”?

Según el contexto, cuando oigo o leo la expresión “suficientemente grande” suelo traducirlo a “nadie lo sabe” o “depende”.

En este caso, afortunadamente, sería un “depende”.

Para comprenderlo mejor, lancemos una moneda al aire varias veces y anotemos las veces que salen cara y cruz, ya lo hago yo por vosotros.

Si lanzamos la moneda diez veces, lo más probable es que consigamos un reparto de 6 caras y 4 cruces, o 4 caras y 6 cruces.

También conseguiríamos 7 caras y 3 cruces, o la inversa, bastantes veces, pero pocas veces conseguiremos exactamente 5 caras y 5 cruces.

Supongamos ahora que lanzamos la moneda cien veces.

La mayoría de las veces, tampoco conseguiríamos un reparto de 50 caras y 50 cruces, sino casi siempre valores en el rango 45-55.

Lo mismo sucedería si la lanzáramos mil veces.

Es muy poco probable obtener 500 caras y 500 cruces pero, la mayoría de las veces, el número de caras y cruces rondarían entre 475 y 525.

Es decir, en un proceso totalmente aleatorio al 50% como es el lanzamiento de una moneda, si lo repetimos muchas veces, no obtendremos un reparto exacto del 50% de caras y cruces, sino un pequeño rango alrededor de este porcentaje y no por ello vamos a pensar que la moneda está trucada.

Quizás empezáis a ver por dónde voy: el reparto de las visitas entre la página de control y la página de variación en un test A/B también se hace aleatoriamente al 50%, de forma que cada página reciba aproximadamente el mismo número de visitas a lo largo del tiempo.

Pero, como hemos visto en el ejemplo de las monedas, la aleatoriedad puede ser caprichosa e introducir pequeños fluctuaciones, completamente al azar, en este reparto.

No ya en lo respecta a que una versión de la página reciba algunas visitas más que la otra versión, sino a que una versión reciba un pequeño número adicional de visitas cualificadas y que, por tanto, incidan directamente en la métrica-objetivo.

Un Test A/B realizado sobre un pequeño número de visitas nunca dará resultados fiables en la evaluación de la métrica-objetivo

Por eso, cuando se dice que la duración del test A/B debe ser “lo suficientemente grande”, significa que debemos asegurarnos que haya suficientes visitas para contrarrestar esos repartos que, por azar, asignan a una versión de la página algunas visitas cualificadas más que a la otra.

¿Cómo analizar los resultados en el A/B testing?

Sin embargo, no basta con tener un número elevado de visitas para eliminar el efecto de la aleatoriedad y analizar los resultados del test, sino que también tenemos que tener en cuenta cuánto cambia la métrica que hayamos elegido para el test.

Veámoslo con un ejemplo...

En nuestro ejemplo inicial, habíamos considerado 10.000 visitas con una tasa de conversión del 1%.

Esto significa 100 conversiones al mes.

Pero pongamos otro caso, de una página con 1.000 visitas y una tasa de conversión del 10%; también supondrían 100 conversiones al mes.

Supongamos que ejecutamos en ambas páginas un test A/B durante un mes, obteniendo el mismo resultado: 95 conversiones en la página de control y 105 conversiones en la página de variación.

¿Qué conclusiones podríamos sacar de estos resultados? ¿En ambos casos es mejor la página de variación?

Por lo pronto, hay que tener en cuenta que la tasa de conversión es, en sí mismo, un valor promedio, lo que significa que también mostrará pequeñas fluctuaciones a lo largo del tiempo.

Con esta consideración en mente, las conversiones obtenidas en el primer ejemplo se traducen en unas tasas de conversión del 0,95% y 1,05% respectivamente, mientras que, en el segundo ejemplo, en unas tasas del 9,5% y 10,5%.

Ya no parece tan claro que la página de variación es mejor en ambos casos, ¿verdad?

Forzado a elegir, me quedaría con la página de control en el primer caso, puesto que la variación no introduce ningún cambio significativo en la tasa de conversión.

Mientras que, en el segundo caso, me quedaría con la página de variación, aunque también analizaría la evolución de tasa de conversión durante los meses anteriores para comprobar hasta qué punto la mejora observada no forma parte de la fluctuación propia de esa métrica.

Como veis, no hay un “número mágico” para la duración de un test A/B ni una “receta infalible” para analizar los resultados, sino que debemos elegirlos cuidadosamente en función del número de visitas, el cambio en la métrica elegida durante el test y la fluctuación de esta métrica en periodos anteriores.

Debemos mentalizarnos con que las “mejoras espectaculares” de una métrica-objetivo solo los conseguiremos paso a paso, test a test.

Por supuesto, si la métrica analizada muestra un margen de mejora enorme (del 10% al 50%, o cosas así), no hay ninguna duda de qué página elegir pero, como ya comprobaréis cuando hagáis vuestros propios tests, estos resultados son poco habituales.

Afortunadamente, a efectos prácticos no tendremos que preocuparnos demasiado de la duración de los tests A/B y de cómo analizar sus resultados.

Las herramientas para realizar tests incluyen mecanismos de análisis estadístico que nos avisan cuando un test ha recopilado los datos necesarios para que los resultados tengan un alto grado de fiabilidad.

Es importante que comprendamos porqué no debemos acortarlos.

¿Se lleva bien el SEO con los A/B Tests?

Quizás ya os lo hayáis preguntado: si tenemos dos versiones de una misma página, ¿no afectará negativamente a su posicionamiento orgánico, puesto que las visitas se reparten entre ellas?

Es más, ¿no podría Google incluso penalizarnos por tener dos páginas distintas con una misma dirección, confundiéndolo con un intento de cloaking?

Lo primero de todo: no, Google ni os penalizará ni afectará vuestro posicionamiento orgánico.

De hecho, Google publicó en su blog oficial que acepta plenamente los Tests A/B, así como otros tipos de tests, puesto que el objetivo de estos es mejorar la experiencia de usuario y hacer un contenido más atractivo y útil para el usuario.

Los Tests A/B no penalizan el SEO de las páginas, hasta el punto que Google anima a hacerlos para mejorar la experiencia de usuario

En ese mismo artículo, Google recomienda buenas prácticas para asegurarnos de no incumplir ninguna de las Directrices para Webmasters ni que Google pueda penalizarnos y que os resumo a continuación:

- No utilizar el test como un pretexto para hacer cloaking. Estamos hablando de páginas muy similares, con diferencias muy pequeñas y localizadas, cuyo acceso no depende de quién (o qué, en caso de tratarse del rastreador de Google) navegue en la página.

- Si la página de control y su variante utilizan direcciones URL distintas, añadir el atributo “rel=’canonical’” en la variante y que apunte a la página de control, para informar a Google que ambas páginas están relacionadas.

- No utilizar la meta-etiqueta “noindex” en la página variante, puesto que puede confundir a Google y hacer que canonice la variante en detrimento de la página original, desechando la dirección de ésta en los índices de búsqueda.

- Si la página de control y su variante tienen la misma URL, siendo el servidor web quien hace la redirección para mostrar la variante, utilizar redirecciones 302 para indicar a Google que es una redirección temporal y que la URL relevante es la original, no la redirigida y así, evitar que Google la indexe en perjuicio de la original.

- Establecer un límite temporal a la ejecución del test. Por definición, estos tests se realizan para diferenciar qué versión de una página proporciona mejores resultados y publicarla como definitiva. Por tanto, no pueden ejecutarse indefinidamente. Si Google detecta un test que lleva ejecutándose “demasiado” tiempo, puede interpretarlo como un intento de manipular los resultados de las búsquedas y penalizarlo. Google no aclara cuánto es “demasiado tiempo”, pues depende de muchos factores, pero el número de visitas nos puede marcar una referencia: a mayor tráfico web, menor necesidad hay de que el test dure más tiempo.

Desde el punto de vista práctico, sólo debemos preocuparnos por el último punto, evitar que el test A/B se ejecute indefinidamente, puesto que el resto depende de que su ejecución esté correctamente implementada en el servidor web o la herramienta que utilicemos.

Ventajas y limitaciones de los Tests A/B

A lo largo de la explicación de los tests A/B y su proceso de ejecución hemos visto algunas de sus ventajas y también de sus limitaciones.

Repasémoslas ahora todas agrupadas para tener una mejor perspectiva de su alcance y posibilidades:

► Ventajas

- Las dos versiones de la página reciben un número similar de visitas durante el mismo periodo de tiempo, por lo que cualquier influencia exterior afectará a ambas por igual y no contaminará la interpretación de los resultados.

- Se minimiza el coste por pérdidas en beneficios, en caso de que el cambio en la página perjudicase el valor de la métrica elegida, pues solo afecta al 50% de las visitas cualificadas (aquellas que visitaron la página variante).

- Al analizar solo un cambio muy concreto en la página original, la evolución de la métrica analizada será exclusivamente debida a ese cambio, facilitando la elección de una versión u otra.

- La duración del experimento puede ser variable, ajustándose al volumen de visitas necesario para obtener resultados relevantes en la métrica seleccionada.

- Se pueden y se deberían hacer tests acumulativos, uno detrás de otro. Es decir, primero sobre un elemento, seleccionando la página ganadora y entonces continuando sucesivamente con otros cambios puntuales en la página.

- La experiencia adquirida con un test A/B, sea positiva o negativa, puede servir para el diseño de futuras páginas con objetivos similares.

► Limitaciones

- Solo se puede comprobar el efecto de un cambio muy localizado dentro del conjunto de la página, por lo que no aporta ninguna referencia para el primer diseño de la página o nuevas campañas.

- A priori, no se sabe qué cambio puede ser más propicio (por ejemplo, qué color, qué texto o qué imagen) y requiere utilizar conjuntamente otros tipos de análisis para identificarlo (por ejemplo, los tests A/B suelen complementarse muy bien con los mapas de calor, como vimos en el ejemplo de las fotos del bebé).

- Puede requerir un alto número de visitas para conseguir acumular suficientes datos para que el análisis de la métrica-objetivo sea relevante y fiable.

- Sólo permite comparar dos versiones de una página. Aunque se puede ampliar para incorporar más versiones, la duración del test también debe ser más larga para recopilar los datos suficientes para analizar los efectos sobre la métrica.

- El reparto de las visitas entre las versiones de la página se mantiene constante y al 50% durante toda la duración del test, incluso cuando la métrica empieza a mostrar una tendencia claramente favorable a alguna de las versiones.

¿Cómo hacer Tests A/B en WordPress?

Existe una gran variedad de plugins para realizar tests A/B en Wordpress, con una amplia gama de funcionalidades y servicios adicionales.

Muchos proveedores ofrecen una versión gratuita, con solo una parte de las funciones disponibles o una versión de prueba sin limitaciones pero por tiempo limitado.

Sin embargo, si nunca hemos realizado antes tests A/B, la curva de aprendizaje con algunos de estos plugins puede distraernos de los aspectos importantes de todo el proceso.

Por otro lado, la mayoría ofrecen también otros tipos de tests, lo que puede complicar aún más su comprensión y configuración.

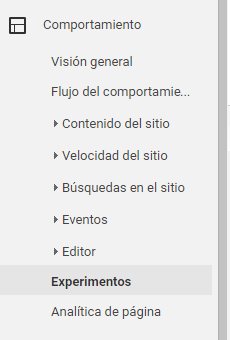

Disponemos de una mejor opción para consolidar los conceptos de los tests A/B y conocer bien su dinámica de ejecución, a través de los Experimentos de Google Analytics, dentro del menú Comportamiento de la pestaña principal de Informes:

Puesto que estamos habituados al entorno y nomenclatura de Google Analytics, la curva de aprendizaje es muy suave y podemos centrar nuestro esfuerzo en lo que realmente importa: comprender, ejecutar y analizar los tests A/B.

Además, al tratarse de una herramienta de Google, nos aseguramos de estar siguiendo las buenas prácticas para ejecutar Tests A/B.

Aunque hay muchos plugins para Tests A/B en WordPress, podemos hacerlos eficazmente con los experimentos de Google Analytics

1 - Crear un experimento nuevo

Suponiendo que sea la primera vez que hacemos un experimento, Analytics muestra un listado en blanco:

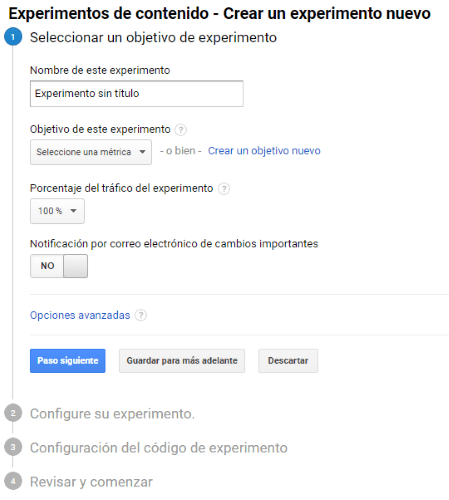

Pulsamos entonces el botón "Crear experimento" y Google nos muestra los cuatro pasos que debemos recorrer y rellenar para configurar nuestro experimento:

Veamos los campos que debemos rellenar en el primer paso, "Seleccionar un objetivo de experimento":

- Nombre de este experimento

El nombre con el que queramos identificar y reconocer este experimento en el listado correspondiente.

Debemos procurar que el nombre sea significativo y relacionado con el objetivo del experimento, por ejemplo: “Tasa de rebote en la página de registro”.

- Objetivo de este experimento

Seleccionar la métrica que hayamos decidido que queremos analizar después de la ejecución del test.

Analytics nos muestra un listado de las métricas disponibles, pero podemos crear nuestros propios objetivos.

- Porcentaje del tráfico del experimento

¡Ojo! No confundirlo con el reparto de visitas al 50% del test A/B: no tiene nada que ver.

Se refiere a qué porcentaje del tráfico total se dedicará a participar en el experimento.

Es decir, si lo ponemos al 60%, el test A/B se realizará sólo sobre un 60% de las visitas.

Lo habitual es que lo dejemos al 100%.

- Notificación por correo de cambios importantes

Introducimos nuestra dirección de correo electrónico para que Analytics nos notifique si se produce alguna incidencia.

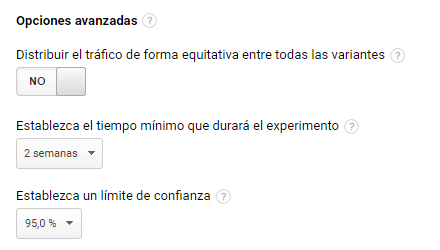

Antes de continuar con el paso siguiente, debemos pulsar el enlace “Opciones avanzadas”, pues es ahí donde configuraremos que vamos a realizar un test A/B:

- Distribuir el tráfico de forma equitativa entre todas las variantes

Debemos seleccionar "Sí".

En caso de seleccionar No, ya no estaríamos haciendo un test A/B tradicional, sino un test adaptativo en función de la métrica seleccionada (por si estáis interesados, este tipo de tests se denominan multi-armed bandits).

- Opciones avanzadas

El resto de opciones avanzadas definen cómo determinará Analytics cuándo hay datos suficientes para completar el experimento.

Los podemos dejar en los valores por defecto.

Observad que Analytics decide por nosotros la duración del experimento, a través del límite de confianza.

Mediante análisis estadístico y el valor de este parámetro, Analytics determina cuándo se han hecho suficientes visitas como para que los resultados del experimento sean suficientemente representativos (tanto para lo bueno como para lo malo).

¡Menudo trabajo nos quita de encima!

2 - Configurar el experimento

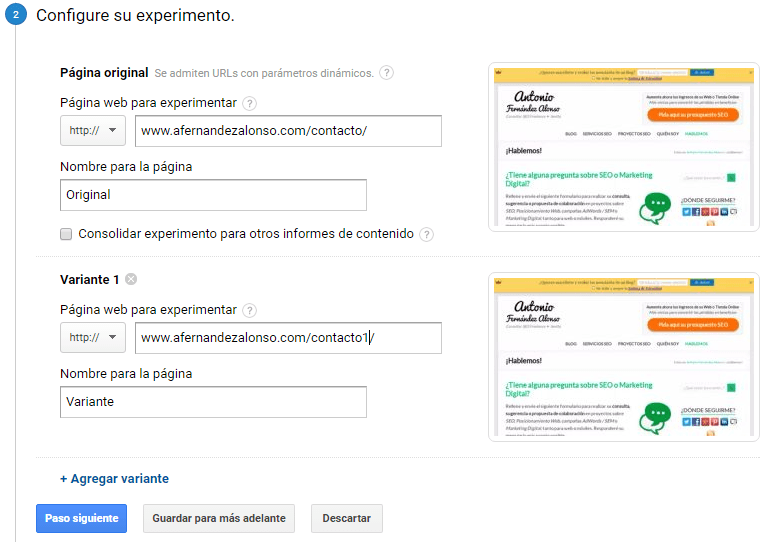

Pulsamos el botón "Paso siguiente" y en el formulario que se nos presenta vamos a introducir las direcciones de la página de control (esto es, la original) y la dirección de la variante (esto es, la página con el cambio que hayamos decidido):

Antes de introducir la dirección URL de la página variante, debemos haberla creado previamente en nuestro WordPress, puesto que Analytics verifica que exista y se cargue correctamente.

Observad que podemos añadir más variantes de la página.

Analytics ofrece posibilidades más allá de los tests A/B, una muestra de su versatilidad pero, también puede complicar el análisis de los resultados y el test llevará más tiempo, puesto que las visitas tienen que repartirse entre más versiones de la página original.

Pulsemos el botón "Paso siguiente".

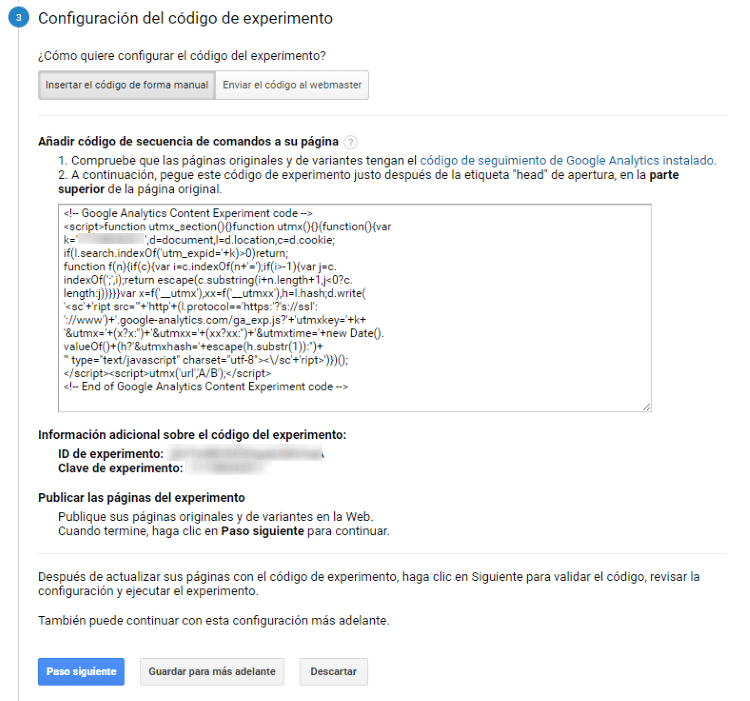

3 - Configuración del código del experimento

Ésta quizás sea la parte más delicada de todo el proceso de configuración de Analytics para dejar operativo nuestro test A/B, puesto que debemos copiar un código JavaScript en la página original del experimento, dentro de la etiqueta <head> del código HTML:

Para quienes tengáis conocimientos técnicos de WordPress, podéis hacerlo introduciendo el siguiente código en el fichero header.php, preferiblemente en el tema-hijo:

<?php

$page_id = [[ El id en Wordpress de la página original del experimento ]]

if (is_page( $page_id )) :

?>

[[ Aquí debemos copiar el código JavaScript del experimento de Analytics ]]

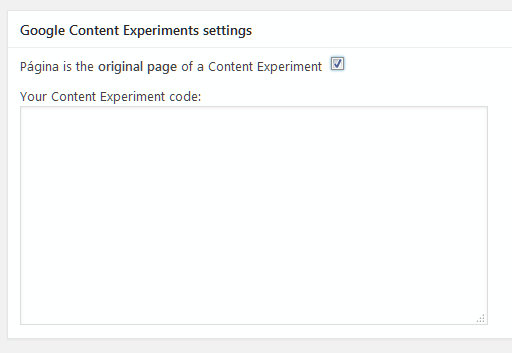

<?php endif; ?>Pero si no queréis tocar las tripas de WordPress, disponéis de un plugin ( Google Content Experiments) que permite añadir este código JavaScript desde la misma pantalla donde se editan las páginas de WordPress, solo en la página original del experimento:

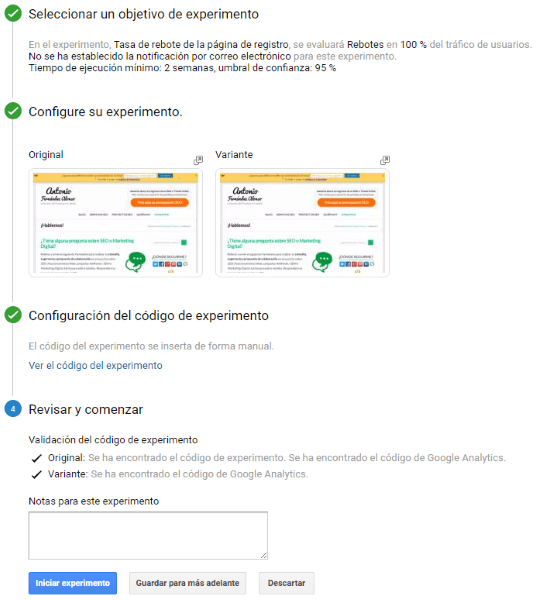

4 - Revisar y comenzar

Una vez copiado este código JavaScript, pulsamos el botón "Paso siguiente" y Analytics verifica que toda la configuración sea correcta:

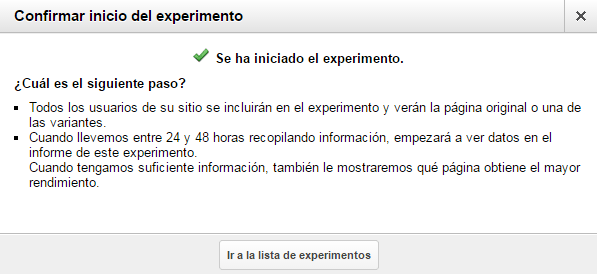

Si todo ha ido correctamente y Analytics no ha detectado ningún error, podemos empezar el test A/B pulsando el botón "Iniciar experimento":

5 - Análisis de los datos del experimento

Aunque los resultados definitivos no los tendremos hasta que Analytics considere que tiene datos suficientes, en función del límite de confianza que hayamos configurado, podremos consultar cómo varía la métrica elegida para la página original y su variante, seleccionando el experimento en el listado:

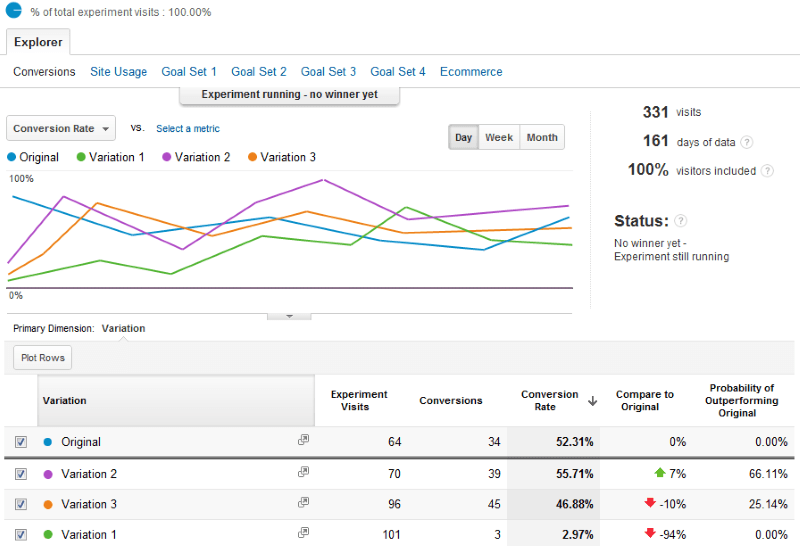

Como pueden pasar varias semanas hasta que Analytics muestre alguna información relevante en el informe, os pongo el siguiente informe de uno que ha estado ejecutándose varios meses y así podamos interpretar la información que muestra:

Como veis, es un experimento más complejo que un test A/B, pues contempla 3 variantes de la página original, por lo que requiere bastante más tiempo de ejecución.

Aunque aún no ha concluido, ya se observa como una de las variantes es una clara perdedora (con un 94% menos de conversiones que la original).

Mientras, otra variante tiene buenas perspectivas como candidata, con un 7% más de conversiones, aunque con una probabilidad de superar al original todavía un poco baja (66,11%), de ahí que Analytics aún no haya dado por concluido el análisis.

En este caso, dado el tiempo que este experimento lleva ejecutándose (más de 5 meses) y sin ningún resultado concluyente, habría que plantearse si vale la pena seguir ejecutándolo.

Una posibilidad, que ofrecería resultados en menos tiempo, sería crear un nuevo experimento, pero que esta vez fuese un verdadero test A/B, con solo la página original y la variante que tiene más probabilidades de éxito.

Conclusiones

Los Tests A/B ofrecen un método para mejorar las métricas de una página web, habitualmente la Landing Page, que tenga, por ejemplo, pocas conversiones, alta tasa de rebote o tiempos cortos de permanencia en página, todo ello, sin tener que invertir en campañas de posicionamiento SEO o SEM.

Con los tests A/B podemos comparar dos versiones de una página web para descubrir cuál de ellas produce mejores resultados.

Aunque no hay límite en lo diferente que pueden ser estas versiones, los cambios deberían implementarse paso a paso, con sucesivos tests que identifiquen cuáles son beneficiosos y desechar los que puedan perjudicarnos.

Si echáis un vistazo rápido al artículo, observaréis que más de las tres cuartas partes del artículo tratan sobre qué son los tests A/B y cómo se deben hacer, mientras que, apenas una cuarta parte explica cómo implementarlo en WordPress.

Esta división no es fruto de la casualidad: la implementación y ejecución propiamente dicha de los tests A/B es increíblemente sencilla.

Lo que realmente marca la diferencia es que comprendamos a fondo su dinámica, qué queremos conseguir, cómo lo podemos conseguir y cómo evaluar los resultados.

Nunca nos precipitemos en ejecutar un test A/B sin estar antes seguros de qué queremos conseguir

Para terminar, un consejo: no esperéis resultados espectaculares después de la ejecución de un único test A/B.

Conseguir tales resultados requiere hacer y analizar muchos tests A/B, hasta encontrar los cambios que, acumulados, proporcionen mejoras importantes.

Los ejemplos de conversiones que se multiplican por 10 debido al cambio de color de un botón son eso: un ejemplo.

Ante tales casos, ejerced un poco como abogados del diablo: si solo el color de un botón pudiera conseguir resultados tan maravillosos, ¿por qué no todos los sitios webs tienen tasas de conversión elevadas?

Con lo que hemos visto en este artículo, ¿cómo crees que podrías haber conseguido mejores resultados?

Y si nunca los has utilizado, ¿se te ocurre dónde podrías hacer tests A/B en tu sitio web?